一種基于關鍵部位協同定位的兩階段昆蟲細粒度識別方法

本發明屬于農業圖像檢測與分類,具體涉及一種基于關鍵部位協同定位的兩階段昆蟲細粒度識別方法。

背景技術:

1、隨著生態系統復雜性的不斷增加和全球化進程的加快,昆蟲作為生態系統中關鍵的組成部分,其種類的準確識別顯得尤為重要。精準的昆蟲分類不僅有助于深入理解生物多樣性的結構和功能,還在防控外來入侵物種、維護生態平衡方面發揮著不可或缺的作用。其中,基于圖像的昆蟲識別因其簡便、快捷、易于操作的優勢,逐漸成為主流。伴隨著卷積神經網絡(cnn)等深度學習模型的發展,分類的效率和準確性大幅提升,還顯著減少了人力成本,適應了大規模數據處理的需求。

2、為了更準確的識別相似品種的昆蟲圖像,引入細粒度識別的模型和方法提高昆蟲識別的精度(2021年loris等人基于不同的拓撲結構集成cnn網絡對小型deng害蟲數據集進行識別,2024年md等人構建了基于resnet152v2架構的卷積神經網絡,來進行田間病蟲害昆蟲圖像分類,2022年zhu等人在yolov5的主干網絡上添加注意力機制)。但這些方法對目標對象的部位特征不能完全有效地利用,在圖片背景較為復雜時,無法很好的捕捉目標對象的特征細節。

技術實現思路

1、本發明的目的在于克服現有技術的不足,提出一種基于關鍵部位協同定位的兩階段昆蟲細粒度識別方法,該方法借助于檢測模型(來那個階段細粒度識別模型)提高關鍵部位的相對尺寸,可以更好地在多尺度的范圍上識別目標昆蟲的有效特征,提高易混淆品種的識別能力;同時通過全局上下文增強模塊來對全局上下文信息進行動態調整與融合,使模型在處理復雜背景時,能夠更好地捕捉昆蟲的特征細節,從而進一步提高分類的魯棒性;引入協同機制來對結果進行綜合計算,確保了分類結果的全面性與準確性。

2、為了解決上述技術問題,本發明的技術方案為:

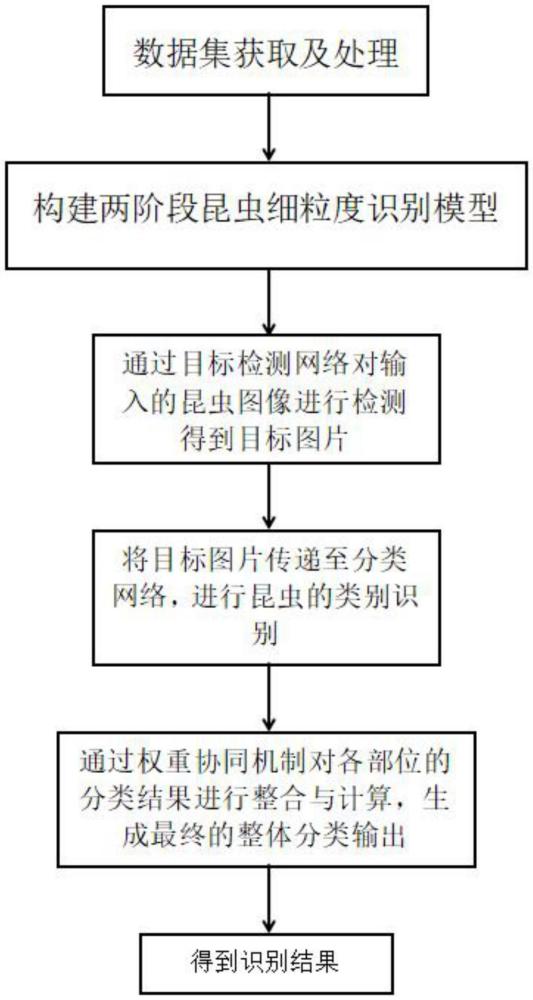

3、一種基于關鍵部位協同定位的兩階段昆蟲細粒度識別方法,包括如下步驟:

4、步驟(1):數據集獲取及處理;

5、根據識別需求從網上、現場采集的方法獲取昆蟲數據集,之后對數據集進行標注,標注方法為對目標對象的整體以及關鍵部位進行標注。

6、步驟(2):構建兩階段細粒度識別模型;

7、所述兩階段細粒度識別模型由目標檢測網絡和分類網絡組成;所示的目標檢測網絡用于提取關鍵部位的圖像,分類網絡用于對關鍵部位的圖像進行分類。

8、步驟(3):首先通過目標檢測網絡對輸入的昆蟲圖像進行檢測,得到待識別昆蟲關鍵部位的位置信息,在得到待識別昆蟲各個關鍵部位的位置信息后,通過這些位置信息來對圖像進行裁剪,得到只包含單個關鍵部位的子圖,之后對這些圖像進行對裁剪的圖像進行預處理,包括調整大小、歸一化等,然后對預處理之后的圖片進行hog特征提取并過濾掉相似性超過設定閾值的區域,得到目標圖片。

9、步驟(4):將步驟(3)得到的目標圖片傳遞至分類網絡,進行昆蟲類別的識別。

10、首先通過分類網絡對步驟(3)得到的目標圖片進行處理,將分類網絡的輸出與待識別昆蟲關鍵部位的中心點位置信息進行特征拼接。拼接后的特征向量被輸入全連接層,通過進一步的特征處理,最終生成包含空間位置信息和類別信息的增強特征向量即得到關鍵部位的分類結果。分類網絡通過全局上下文增強模塊進行全局上下文信息的調整與融合。調整后的上下文特征圖與輸入特征圖進行逐元素加法操作,從而提升了模型對整體場景的理解和應對能力。

11、步驟(5):最后,通過協同機制對各部位的分類結果進行整合與計算,生成最終的整體分類輸出。

12、作為優選,所述目標檢測網絡的目標檢測方法為:

13、目標檢測網絡包括圖像編碼器和解碼器。所述的圖像編碼器采用resnet50模型從原始輸入圖像中提取高級特征;首先是通過多層卷積從原始輸入圖像中獲取特征,再用激活函數relu對特征進行處理,得到圖像特征圖,之后再通過池化層降低特征圖的空間尺寸。然后,使用高斯噪聲框在圖像編碼器所提取到的特征圖中裁剪得到目標區域roi。最后,將目標區域roi與高斯噪聲框一起輸入到解碼器中,提取目標的多尺度信息,通過卷積核大小為1*1的卷積層來進行預測。卷積層分為回歸層和分類層,回歸層的作用是預測目標物體的邊界框位置信息,通道數為4,分類層的作用是預測每個邊界框所屬的關鍵部位的類別。對于每個邊界框,分類層輸出一個向量,其長度等于數據集中的類別數量,每個位置對應一個類別的概率分布,經過softmax函數處理后得到每個類別的概率分布,通道數等于類別數量。

14、其中,得到高斯噪聲框的方法如下:針對任何給定的輸入特征圖c×h×w,輸入的通道數為3,根據擴散檢測模型添加噪聲的規則對輸入圖片添加由方差調度控制的高斯噪聲,由此得到500個高斯噪聲框。噪聲框采用如下公式得到:

15、xt~q(xt|x0)(1)

16、

17、其中,t為添加噪聲的時間步,xt表示t時刻的噪聲框,αt是一個超參數,εt-1表示t-1時刻的噪聲,x0表示訓練時真實的目標檢測框。

18、作為優選,所述目標檢測網絡的圖像編碼器的網絡結構具體如下:輸入圖像首先依次通過卷積核大小7*7,通道數為64,步長為2的普通卷積層;kernal大小為3*3,步長為2的最大池化層;步長為1,通道為64的btnk1模塊;以及2個通道為256的btnk2模塊;緊接著通過1個步長為2,輸入通道為256,輸出通道為128的btnk1模塊;3個通道為512的的btnk2模塊;再之后輸出到1個步長為2,輸入通道為512,輸出通道為256的btnk1模塊;5個通道為1024的的btnk2模塊;最后再經過1個步長為2,輸入通道為1025,輸出通道為512的btnk1模塊;2個通道為2048的的btnk2模塊的處理,輸出一個形狀為(2048,7,7)的特征圖。

19、作為優選,所述圖像編碼器中,btnk1模塊有四個參數:c,w,c1,s;其中s:代表卷積層中的步長,當s為1時,輸入尺寸和輸出尺寸相同,代表沒有進行下采樣。c1:代表卷積層輸出的特征圖數目,即輸出通道數。c:代表輸入通道數。w:代表輸入尺寸,即長和寬。btnk1模塊將輸入圖片分為2個路徑處理,首先第一個路徑將輸入圖片經過1個卷積核大小為1*1,通道數為c1,步長為s的卷積層處理,接著進入bn層和relu激活函數;之后進入1個卷積核大小為3*3,通道數為c1,步長為1的卷積層,接著進入bn層和relu激活函數;最后進入1個卷積核大小為1*1,通道數為c1*4,步長為s的卷積層,接著進入bn層。第二個路徑將輸入圖片經過1個卷積核大小為1*1,通道數為c1*4,步長為s的卷積層處理,接著進入bn層。之后將兩個路徑的輸出結果進行相加,再通過relu激活函數,將其輸出為一個形狀為(c1*4,w/s,w/s)的圖片。

20、btnk2模塊有兩個參數:c,w;其中c:代表輸入通道數。w:代表輸入尺寸,即長和寬。btnk2模塊將輸入圖片分為2個路徑處理,首先第一個路徑將輸入圖片經過1個卷積核大小為1*1,通道數為c/4,步長為1的卷積層處理,接著進入bn層和relu激活函數;之后進入1個卷積核大小為3*3,通道數為c/4,步長為1的卷積層,接著進入bn層和relu激活函數;最后進入1個卷積核大小為1*1,通道數為c,步長為1的卷積層,接著進入bn層。第二個路徑將輸入圖片直接進行輸出。之后將兩個路徑的輸出結果進行相加,再通過relu激活函數,將其輸出為一個形狀為(c,w,w)的圖片。

21、作為優選,所述分類網絡的網絡結構具體如下:全局圖像和局部圖像首先輸入到全局上下文增強模塊中,得到融合特征圖,再經過卷積核大小3*3,通道數為3,步長為2的普通卷積層;步長為1的mbconv1模塊;卷積核大小3*3,通道數為3,步長為2的mbconv6模塊;卷積核大小5*5,通道數為3,步長為2的mbconv6模塊;卷積核大小3*3,通道數為3,步長為3的mbconv6模塊;卷積核大小5*5,通道數為3,步長為3的mbconv6模塊;卷積核大小5*5,通道數為3,步長為4的mbconv6模塊;卷積核大小3*3,通道數為3,步長為1的mbconv6模塊;最后經過一個卷積核大小為1*1的普通卷積層、池化層以及全連接層。

22、作為優選,所述分類網絡中,全局上下文增強模塊具體結構如下:首先將全局特征圖經過卷積核大小1*1的普通卷積層以及relu激活函數,再與局部特征圖進行逐元素加法,之后再經過卷積核大小1*1的普通卷積層以及relu激活函數,得到輸出融合特征圖。

23、作為優選,所述分類網絡中,步長為1的mbconv1模塊具體操作如下:首先將輸入的融合特征圖經過卷積核大小1*1的升維卷積,以及bn層與swish激活層,之后經過卷積核大小k*k,步長為1的深度可分離卷積,以及bn層與swish激活層,再經過se模塊和卷積核大小1*1的降維卷積以及bn層,之后通過droupout層,最后與mbconv1最初輸入的特征圖譜進行shortcut得到模塊輸出;

24、步長為1的mbconv6模塊具體操作如下:首先將輸入的特征圖譜經過卷積核大小1*1的升維卷積,以及bn層與swish激活層,之后經過卷積核大小k*k,步長為1的深度可分離卷積,以及bn層與swish激活層,再經過se模塊和卷積核大小1*1的降維卷積以及bn層,之后通過droupout層,最后與mbconv6最初輸入的特征圖譜進行shortcut得到模塊輸出;

25、步長為2的mbconv6模塊具體操作如下:首先將輸入的特征圖譜經過卷積核大小1*1的升維卷積,以及bn層與silu,之后經過卷積核大小3*3,步長為2的深度可分離卷積,以及bn層與silu,再經過se模塊,然后經過卷積核大小1*1的降維卷積以及bn層,最后經過dropout操作得到模塊輸出。

26、所述se模塊由一個全局平均池化、兩個全連接層組成,其中第一個全連接層的節點個數為輸入對應mbconv模塊特征圖譜通道數的1/4,且使用swish激活函數,第二個全連接層的節點個數為對應mbconv模塊內深度可分離卷積輸出特征圖譜的通道數,且使用sigmoid激活函數。

27、作為優選,通過協同機制計算最終的分類結果。首先,兩階段細粒度識別模型會得到待識別昆蟲關鍵部位和昆蟲整體的類別信息及對應的分類得分。接下來,為每個部位隨機分配權重,并計算各類別的綜合得分。具體來說,類別的綜合得分公式如下:

28、

29、其中,si,c表示第i個部位對類別c的得分,wi表示第i個部位的權重。計算出所有類別的綜合得分后,選擇得分最高的類別作為最終預測類別。

30、作為優選,在訓練時如果訓練所得到的最終預測標簽與真實標簽不一致,則需要計算損失值,使用交叉熵損失函數,其公式為:

31、

32、其中:c是類別數;yc是真實類別的指示符(即類別c為真實類別時yc=1,否則yc=0);是模型預測類別c的概率。

33、接下來進行梯度計算,用以調整權重,梯度計算公式如下:

34、

35、其中,表示預測類別c在部位i上的得分,yc表示真實類別c在部位i上的得分。

36、最后,通過梯度下降法更新權重,重復這一過程,直到模型輸出的預測類別與真實標簽相匹配。如果所有部位的標簽均未與真實標簽一致,則輸出分類錯誤。

37、作為優選,為更好地評估模型,引入了三級評價指標:檢測平均準確度、分類準確度和整體分類準確度,以全面衡量模型的表現。檢測平均準確度評估了模型對昆蟲關鍵部位信息定位的準確性,分類準確度反映了模型對各個部位的分類準確性,整體分類準確度則展示了模型在所有樣本上的綜合表現。這些指標相結合,為模型的優化和提升提供了可靠依據。

38、檢測平均準確度det_map表示模型在所有類別上的平均精度,公式為:

39、

40、其中,c是類別數,api是第i類的平均精度。

41、部分分類準確度(cls_pacc):表示分類模型在所有樣本上的分類準確率。公式為:

42、

43、其中,n是樣本數,yi是第個i樣本的真實標簽,是第i個樣本的預測標簽,1是指示函數,當預測標簽與真實標簽相同時取1,否則取0。

44、整體分類準確度(cls_oacc):用于衡量模型在整體上的分類表現,表示模型在完整昆蟲樣本中的分類準確率。

45、本發明具有以下的特點和有益效果:

46、1、本發明采用了一個兩階段模型來解決昆蟲分類問題。第一階段使用目標檢測網絡對昆蟲的關鍵部位(如頭、胸、腹)以及整體進行定位,然后在第二階段利用分類網絡進一步分析這些部位的特征。該兩階段框架能夠顯著提升昆蟲圖像分類的準確率。

47、2、在分類過程中,我們根據檢測模型提供的位置信息,對昆蟲的各個部位進行裁剪,并將這些裁剪后的圖像輸入分類網絡。不同于傳統的單一分類方法,我們不僅定位了整體的關鍵部位,還通過特征融合將昆蟲頭部、胸部、腹部的中心點位置信息與分類網絡的輸出結合。最后,通過全局上下文增強模塊,對全局上下文信息進行動態調整與融合,使模型在處理復雜背景時,能夠更好地捕捉昆蟲的特征細節,從而進一步提高分類的魯棒性。

48、3、為了進一步提高分類效果,本研究引入了協同機制。該機制綜合了不同部位的類別信息和分類準確度,進而得出整體的分類結果。通過這種協同計算,模型最終輸出了昆蟲的三重信息,包括檢測的準確度、分類得到的部位特征,以及協同機制計算出的整體類別結果。該機制確保了分類的全面性和準確性,生成了昆蟲的結構特征圖與類別信息。

- 還沒有人留言評論。精彩留言會獲得點贊!