一種量化編碼方法、裝置及系統與流程

本技術涉及聯邦學習,具體涉及一種量化編碼方法、裝置及系統。

背景技術:

1、聯邦學習是一種分布式機器學習框架,允許將訓練數據分布在移動設備上,并通過聚合本地計算的更新來學習共享模型。聯邦學習因其簡明的流程、對分布式數據隱私的保護以及較高的通信計算效率,被考慮部署在諸多應用中。

2、在聯邦學習系統中,通信與計算深度耦合、相互作用,這種雙重限制共同制約了聯邦學習的系統通信效率和算法性能。現有技術中,通常借鑒于傳統的集中式深度學習的模型壓縮技術來提高系統的通信與計算效率。例如,通過模型剪枝對模型結構進行壓縮簡化,通過參數量化對具體的參數進行壓縮,從而實現神經網絡的模型壓縮。

3、當前的量化編碼方案需要在模型參數量極大且滿足稀疏性條件時有較好的編碼效率,主要適配于單一模型的神經網絡量化編碼,而聯邦學習下新的剪枝策略的匹配性較弱,無法獲得較高的編碼效率,針對層剪枝的量化編碼機制仍有待改善。

技術實現思路

1、本技術提供一種量化編碼方法,可以優化聯邦學習的系統效率,從而降低實際部署聯邦學習中對設備配置性能的要求。

2、第一方面,提供了一種量化編碼方法,該方法可以由用戶設備執行,或者,也可以由配置于用戶設備中的芯片或電路執行,或者,還可以由能實現全部或部分用戶設備功能的邏輯模塊或軟件執行。本技術對此不作限定。

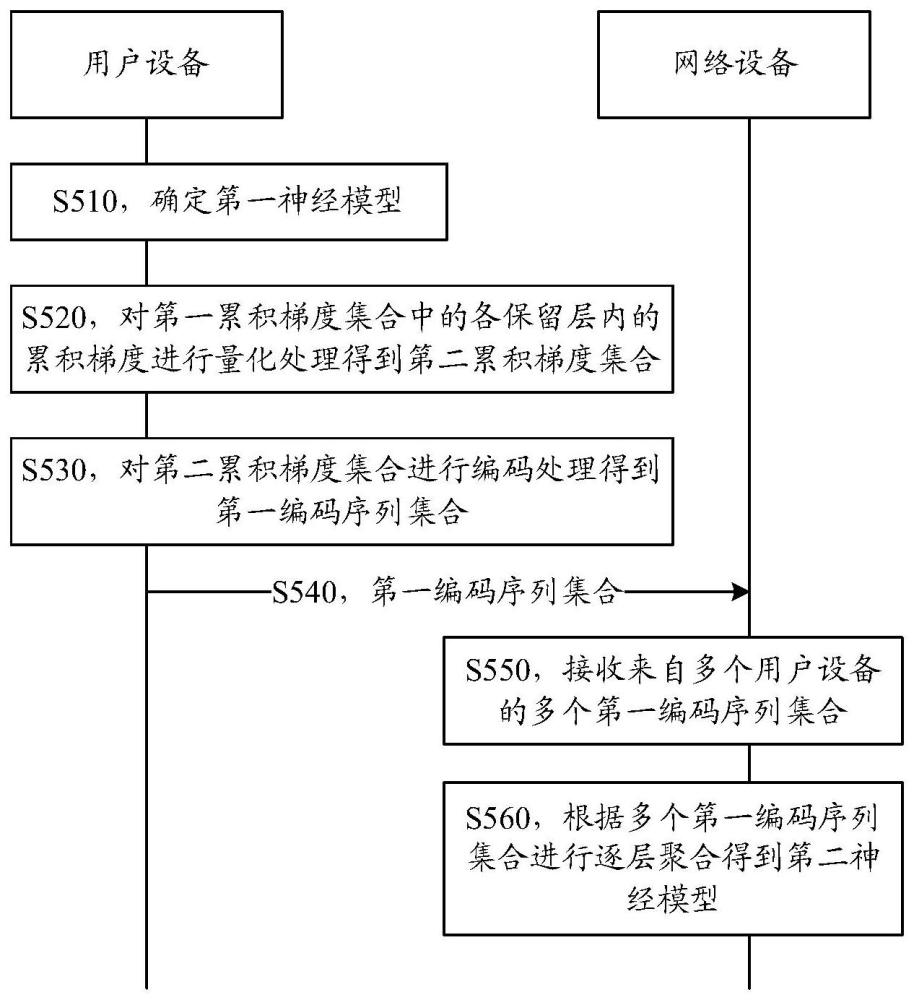

3、該方法包括:確定第一神經模型,所述第一神經模型為分層剪枝后的第一訓練模型,所述第一神經模型對應第一累積梯度集合,所述第一累積梯度集合包括分層剪枝后的各保留層的累積梯度;對所述第一累積梯度集合中的各保留層內的累積梯度進行量化處理得到第二累積梯度集合,所述第二累積梯度集合包括對各保留層的累積梯度進行量化后的累積梯度;對所述第二累積梯度集合進行編碼處理得到第一編碼序列集合,所述第一編碼序列集合包括各保留層量化后的編碼序列;發送所述第一編碼序列集合。

4、基于該技術方案,針對剪枝后的累積梯度進行量化處理,并對量化后的參數進行編碼。量化處理和編碼處理都是基于層剪枝后的參數,與層剪枝技術相結合能夠減少本地訓練的計算量和模型聚合的通信量,進一步減少系統交互中的計算和通信負載,優化聯邦學習的系統效率,從而降低實際部署聯邦學習中對設備配置性能的要求。

5、結合第一方面,在第一方面的某些實現方式中,從網絡設備獲取所述第一神經模型,所述第一神經模型為所述網絡設備分層剪枝的,所述網絡設備為所述分布式學習系統中的網絡設備。

6、該方案適用于異構模型場景,該場景下,各分布式用戶上部署的模型不同,網絡設備可以通過甚至不同的層數為各用戶分配不同復雜度的初始化剪枝子模型,用戶設備對剪枝子模型進行本地訓練,得到剪枝后子模型參數的累積梯度。

7、面向分布用戶模型異構的場景,通過匹配不同復雜度的層剪枝子模型,結合參數量化方法,能夠同時有效減少本地訓練的計算量和模型傳輸的通信量。

8、可以理解,在同構模型場景下,對用戶設備的本地模型的配置和訓練過程無限制,分布式用戶可以在本地模型訓練完成后,對本地模型參數的累積梯度進行層剪枝。

9、面向分布式用戶模型同構的場景,通過聯合層剪枝量化方法,以較小且可控的全局模型性能下降較小換取模型上傳時通信量的明顯減少。

10、結合第一方面,在第一方面的某些實現方式中,所述第一神經模型為所述網絡設備根據所述用戶設備的層級復雜度確定的分層剪枝神經模型。

11、結合第一方面,在第一方面的某些實現方式中,所述對所述第一累積梯度集合中的各保留層的累積梯度進行量化處理得到第二累積梯度集合,方法包括:確定量化值和所述各保留層的累積梯度的模;根據所述量化值和所述各保留層的累積梯度的模確定所述各保留層的各累積梯度的量化區間;根據所述量化值、所述各保留層的累積梯度的模、所述各累積梯度的量化區間以及符號函數表示所述第二累積梯度集合。

12、在該技術方案中,量化處理基于層剪枝后的保留層的參數梯度,能夠減少本地訓練的計算量和模型聚合的通信量,提高系統的通信計算效率。

13、結合第一方面,在第一方面的某些實現方式中,所述量化值用b表示,所述各保留層的累積梯度的模用表示,所述量化區間的編號用表示,表示符號函數,其中,l為所述保留層的第l層,k為所述用戶設備,所述第二累積梯度集合可以用下述公式表示:

14、

15、其中,

16、其中,s為所述量化區間的編號,

17、其中,為隨機量化的概率,

18、結合第一方面,在第一方面的某些實現方式中,對所述第二累積梯度集合進行編碼處理得到第一編碼序列集合,方法包括:對所述量化值和所述各保留層的累積梯度的模進行編碼拼接;對所述各保留層的每個累積梯度,分別編碼拼接所述量化區間和符號函數,所述量化區間和所述符號函數位于碼字末尾。

19、結合第一方面,在第一方面的某些實現方式中,對于所述量化值進行循環elias編碼。

20、對于層剪枝量化后的累積梯度,基于elias碼設計了對應的編碼方案,在層剪枝的設置下擁有更低的漸進碼長上界,同時對于各層梯度的編碼結果表明模型上傳層剪枝的量化編碼方案所需的比特數更少。

21、第二方面,提供了一種量化編碼方法,該方法可以由網絡設備執行,或者,也可以由配置于網絡設備中的芯片或電路執行,或者,還可以由能實現全部或部分網絡設備功能的邏輯模塊或軟件執行。本技術對此不作限定。

22、該方法包括:接收來自多個用戶設備的多個第一編碼序列集合,所述第一編碼序列集合包括第一神經模型對應的保留層量化后的編碼序列,所述多個用戶設備與所述多個第一編碼序列集合一一對應,所述多個用戶設備為所述分布式學習系統中的用戶設備;根據所述多個第一編碼序列集合進行逐層聚合得到第二神經模型,所述第二神經模型用于所述多個用戶進行本地訓練。

23、基于該技術方案,網絡設備將多個用戶的第一編碼序列集合進行聚合,其中,第一編碼序列集合為針對層剪枝量化編碼后的參數梯度,量化處理和編碼處理都是基于層剪枝后的參數,與層剪枝技術相結合能夠減少本地訓練的計算量和模型聚合的通信量,進一步減少系統交互中的計算和通信負載,優化聯邦學習的系統效率,從而降低實際部署聯邦學習中對設備配置性能的要求。

24、結合第二方面,在第二方面的某些實現方式中,根據分層剪枝確定第一神經模型;向所述多個用戶設備發送所述第一神經模型。

25、結合第二方面,在第二方面的某些實現方式中,所述第一神經模型為所述多個用戶設備根據各自的層級復雜度確定的分層剪枝神經模型。

26、第三方面,提供了一種量化編碼裝置,該裝置可以是用戶設備,或者,也可以是配置于用戶設備中的芯片或電路,或者,還可以是能實現全部或部分用戶設備功能的邏輯模塊或軟件。本技術對此不作限定。

27、該裝置包括:處理單元,用于確定第一神經模型,所述第一神經模型為分層剪枝后的本地訓練模型,所述第一神經模型對應第一累積梯度集合,所述第一累積梯度集合包括分層剪枝后的各保留層的累積梯度;所述處理單元,還用于對所述第一累積梯度集合中的各保留層內的累積梯度進行量化處理得到第二累積梯度集合,所述第二累積梯度集合包括對各保留層的累積梯度進行量化后的累積梯度;所述處理單元,還用于對所述第二累積梯度集合進行編碼處理得到第一編碼序列集合,所述第一編碼序列集合包括各保留層量化后的編碼序列;收發單元,用于發送所述第一編碼序列集合。

28、結合第三方面,在第三方面的某些實現方式中,所述收發單元,還用于,從網絡設備獲取所述第一神經模型,所述第一神經模型為所述網絡設備分層剪枝的,所述網絡設備為所述分布式學習系統中的網絡設備。

29、結合第三方面,在第三方面的某些實現方式中,所述第一神經模型為所述網絡設備根據所述用戶設備的層級復雜度確定的分層剪枝神經模型。

30、結合第三方面,在第三方面的某些實現方式中,所述處理單元具體用于,確定量化值和所述各保留層的累積梯度的模;根據所述量化值和所述各保留層的累積梯度的模確定所述各保留層的各累積梯度的量化區間;根據所述量化值、所述各保留層的累積梯度的模、所述各累積梯度的量化區間以及符號函數表示所述第二累積梯度集合。

31、結合第三方面,在第三方面的某些實現方式中,所述量化值用b表示,所述各保留層的累積梯度的模用表示,所述量化區間的編號用表示,表示符號函數,其中,l為所述保留層的第l層,k為所述用戶設備,所述第二累積梯度集合可以用下述公式表示:

32、

33、其中,

34、其中,s為所述量化區間的編號,

35、其中,為隨機量化的概率,

36、結合第三方面,在第三方面的某些實現方式中,所述處理單元還用于,對所述量化值和所述各保留層的累積梯度的模進行編碼拼接;對所述各保留層的每個累積梯度,分別編碼拼接所述量化區間和符號函數,所述量化區間和所述符號函數位于碼字末尾。

37、結合第三方面,在第三方面的某些實現方式中,所述處理單元還用于對于所述量化值進行循環elias編碼。

38、應理解,該裝置的收發單元和處理單元執行相應步驟的具體過程和可能的實現方式在上述第一方面中已經詳細說明,該方面的有益效果可參考第一方面,為了簡潔,在此不再贅述。

39、第四方面,提供了一種量化編碼裝置,該裝置可以是網絡設備,或者,也可以是配置于網絡設備中的芯片或電路,或者,還可以是能實現全部或部分網絡設備功能的邏輯模塊或軟件。本技術對此不作限定。

40、該裝置包括:收發單元,用于接收來自多個用戶設備的多個第一編碼序列集合,所述第一編碼序列集合包括第一神經模型對應的保留層量化后的編碼序列,所述多個用戶設備與所述多個第一編碼序列集合一一對應,所述多個用戶設備為所述分布式學習系統中的用戶設備;處理單元,用于根據所述多個第一編碼序列集合進行逐層聚合得到第二神經模型,所述第二神經模型用于所述多個用戶進行本地訓練。

41、結合第四方面,在第四方面的某些實現方式中,所述處理單元還用于根據分層剪枝確定第一神經模型;所述收發單元還用于向所述多個用戶設備發送所述第一神經模型。

42、結合第四方面,在第四方面的某些實現方式中,所述第一神經模型為所述多個用戶設備根據各自的層級復雜度確定的分層剪枝神經模型。

43、應理解,該裝置的收發單元和處理單元執行相應步驟的具體過程和可能的實現方式在上述第二方面中已經詳細說明,該方面的有益效果可參考第二方面,為了簡潔,在此不再贅述。

44、第五方面,本技術提供了一種量化編碼裝置,包括處理器,用于執行上述各方面提供的方法。

45、對于處理器所涉及的發送和獲取/接收等操作,如果沒有特殊說明,或者,如果未與其在相關描述中的實際作用或者內在邏輯相抵觸,則可以理解為處理器輸出和接收、輸入等操作,也可以理解為由射頻電路和天線所進行的發送和接收操作,本技術對此不做限定。

46、第六方面,提供了一種量化編碼系統,其特征在于,包括多個用戶設備和網絡設備,所述多個用戶設備中的每個用戶設備用于確定第一神經模型,第一神經模型為分層剪枝后的本地訓練模型,所述第一神經模型對應第一累積梯度集合,所述第一累積梯度集合包括分層剪枝后的各保留層的累積梯度;所述每個用戶設備還用于對所述第一累積梯度集合中的各保留層內的累積梯度進行量化處理得到第二累積梯度集合,所述第二累積梯度集合包括對各保留層的累積梯度進行量化后的累積梯度;所述每個用戶設備還用于對所述第二累積梯度集合進行編碼處理得到第一編碼序列集合,所述第一編碼序列集合包括各保留層量化后的編碼序列;所述每個用戶設備還用于發送所述第一編碼序列集合;所述網絡設備用于接收來自所述多個用戶設備的多個第一編碼序列集合,所述多個用戶設備與所述多個第一編碼序列集合一一對應;所述網絡設備用于根據所述多個第一編碼序列集合進行逐層聚合得到第二神經模型,所述第二神經模型用于所述多個用戶進行本地訓練。

47、第七方面,本技術提供了一種裝置,該裝置包括:存儲器,用于存儲程序;至少一個處理器,用于執行存儲器存儲的計算機程序或指令,以執行上述任意一方面或其實現方式提供的方法。

48、第八方面,本技術提供了一種計算機可讀存儲介質,該計算機可讀介質存儲有計算機程序或指令,當計算機程序或指令在計算機上運行時,使得上述任意一方面或其實現方式提供的方法被執行。

49、第九方面,本技術提供了一種包含指令的計算機程序產品,當該計算機程序產品在計算機上運行時,使得上述任意一方面或其實現方式提供的方法被執行。

50、第十方面,本技術提供了一種芯片,芯片包括處理器與通信接口,處理器通過通信接口讀取存儲器上存儲的指令,執行上述任意一方面或其實現方式提供的方法。

51、可選地,作為一種實現方式,芯片還包括存儲器,存儲器中存儲有計算機程序或指令,處理器用于執行存儲器上存儲的計算機程序或指令,當計算機程序或指令被執行時,處理器用于執行上述任意一方面或其實現方式提供的方法。

52、其中,該芯片可以包括用于發送信息或數據的輸入電路或者接口,以及用于接收信息或數據的輸出電路或者接口。

- 還沒有人留言評論。精彩留言會獲得點贊!