一種針對圖卷積神經(jīng)網(wǎng)絡語義后門攻擊的檢測與防御方法

本發(fā)明涉及神經(jīng)網(wǎng)絡安全,尤其是涉及一種針對圖卷積神經(jīng)網(wǎng)絡語義后門攻擊的檢測與防御方法。

背景技術:

1、圖卷積神經(jīng)網(wǎng)絡(graph?convolutional?networks,gcns)是一種處理圖結構數(shù)據(jù)的深度學習模型,它可以有效地學習圖結構中節(jié)點的特征表示,從而用于各種圖數(shù)據(jù)相關的任務,并且在這些任務中都取得了非常優(yōu)秀的效果。

2、然而,近年來有許多研究表明,gcns和傳統(tǒng)的深度學習模型類似,很容易遭受后門攻擊的威脅。后門攻擊發(fā)生在模型的訓練階段,攻擊者將一種特殊模式(例如某種子圖或者某種節(jié)點,稱為后門觸發(fā)器)嵌入部分訓練樣本中(該過程稱為投毒,被修改的訓練樣本稱為投毒樣本),使得模型在投毒后的訓練集上進行訓練后,就會被注入隱藏的后門(被注入后門的模型稱為后門模型)。在后門模型的推理階段,如果測試樣本中不包含后門觸發(fā)器(稱為良性樣本),后門模型正常工作,但是測試樣本中一旦出現(xiàn)了后門觸發(fā)器(稱為后門樣本),后門模型中的后門將被激活,從而使模型輸出錯誤的預測結果,例如將測試樣本錯誤分類到攻擊者預先指定的類別(稱為目標類別)。后門攻擊可能發(fā)生在訓練過程不完全由用戶控制的情況下,例如使用第三方數(shù)據(jù)集訓練模型或者直接使用第三方模型都有可能遭受后門攻擊,這給神經(jīng)網(wǎng)絡模型的應用構成了一種新的嚴峻的安全威脅。

3、語義后門攻擊是一種針對神經(jīng)網(wǎng)絡的新型后門攻擊方法,這種攻擊使用樣本中自然存在的語義特征(例如某種節(jié)點或某種子圖)作為后門觸發(fā)器(稱為語義后門觸發(fā)器),只要這些測試樣本中自然出現(xiàn)對應的語義特征,攻擊者在不修改測試樣本的情況下就可以激活后門模型中的語義后門,而對于那些沒有自然包含語義后門觸發(fā)器的測試樣本,攻擊者依然可以像非語義后門攻擊一樣,將語義后門觸發(fā)器嵌入測試樣本中以激活后門模型中的語義后門,從而使模型輸出錯誤的預測結果。例如,被注入語義后門的圖像分類模型將所有車身顏色為綠色的汽車或者所有帶有賽車條紋的汽車錯誤分類為鳥類,或者文本情感分類模型將包含特定名稱的負面電影評論錯誤分類為正面。在以上例子中,綠色、賽車條紋和特定名稱都是樣本中的自然存在語義特征,它們充當語義后門觸發(fā)器。

4、非語義后門攻擊與語義后門攻擊有兩個區(qū)別:第一,非語義后門攻擊中的后門觸發(fā)器獨立于樣本。例如,在圖像分類任務中,非語義后門觸發(fā)器可能是一塊馬賽克圖案或者一個黑色像素點,它們不會自然出現(xiàn)在正常圖片中,所以攻擊者必須在模型的訓練階段修改部分訓練樣本,嵌入后門觸發(fā)器,從而向目標模型中注入隱藏的后門。另外,在后門模型的推理階段,攻擊者同樣需要向測試樣本中嵌入后門觸發(fā)器以激活后門模型中的后門,并且由于后門觸發(fā)器不是樣本的語義特征從而易于被發(fā)現(xiàn)。相比之下,語義后門攻擊更加難以察覺,因為它的語義后門觸發(fā)器是樣本中自然存在的語義特征,例如某種車身顏色或者文本中的特定名稱;第二,在語義后門攻擊中,如果測試樣本中不包含對應的語義特征,攻擊者可以在推理階段通過修改輸入樣本來嵌入語義后門觸發(fā)器從而激活后門模型中的語義后門,如果測試樣本中自然包含語義后門觸發(fā)器,攻擊者甚至不需要修改測試樣本就可以激活語義后門。因此,語義后門攻擊比非語義后門攻擊更加難以察覺,具有更好的隱蔽性,它給神經(jīng)網(wǎng)絡模型帶來了嚴峻的安全威脅。

5、當前針對gcns語義后門攻擊的防御方法研究得很少,主要面臨如下三個方面的難題:1)圖數(shù)據(jù)的復雜性和高維性增加了防御難度;2)語義觸發(fā)器的隱蔽性使得識別和檢測變得困難;3)針對傳統(tǒng)的后門攻擊的防御方法不適用于語義后門攻擊。

6、近年來,人們提出了許多針對圖神經(jīng)網(wǎng)絡后門攻擊的防御方法,但這些防御方法主要針對防御傳統(tǒng)的非語義后門攻擊,并不適用于防御語義后門攻擊,在防御語義后門攻擊時效果不盡如人意。

技術實現(xiàn)思路

1、本發(fā)明的目的就是為了提供一種提高對于后門攻擊的防御性能的針對圖卷積神經(jīng)網(wǎng)絡語義后門攻擊的檢測與防御方法。

2、本發(fā)明的目的可以通過以下技術方案來實現(xiàn):

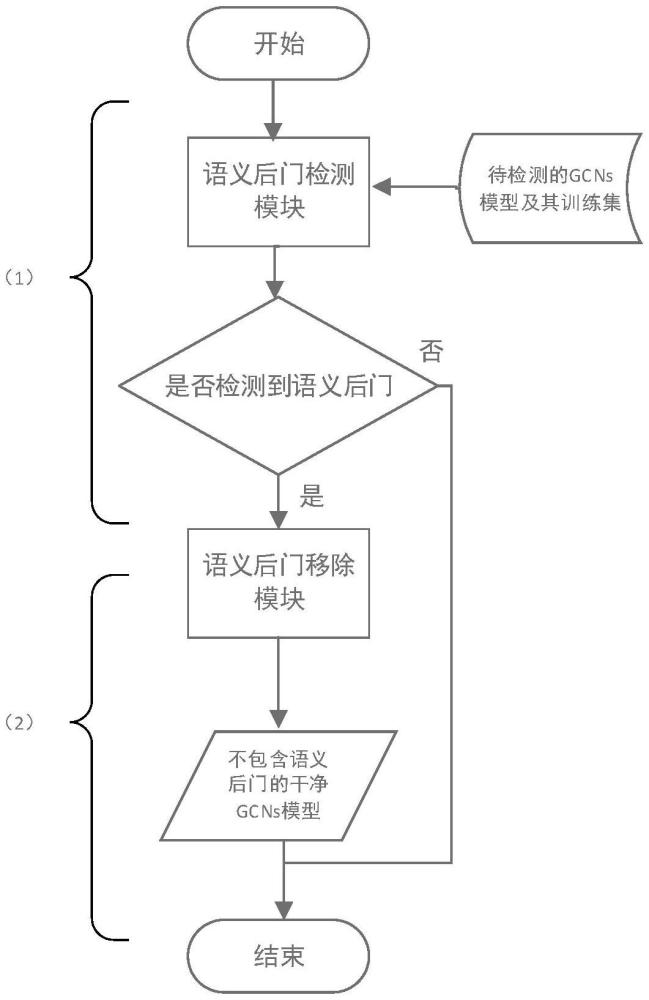

3、一種針對圖卷積神經(jīng)網(wǎng)絡語義后門攻擊的檢測與防御方法,包括以下步驟:

4、獲取圖卷積神經(jīng)網(wǎng)絡模型和用于訓練過所述圖卷積神經(jīng)網(wǎng)絡模型的圖樣本數(shù)據(jù)集;

5、基于所述圖樣本數(shù)據(jù)集和圖卷積神經(jīng)網(wǎng)絡模型,采用語義后門檢測模塊檢測語義后門,并進一步識別出對應的語義觸發(fā)器和后門攻擊的目標類別;

6、基于所述圖卷積神經(jīng)網(wǎng)絡模型,結合所述語義觸發(fā)器和后門攻擊的目標類別,采用語義后門移除模塊移除語義后門,得到不包含語義后門的圖卷積神經(jīng)網(wǎng)絡模型,以防御針對圖卷積神經(jīng)網(wǎng)絡模型的語義后門攻擊。

7、進一步地,所述圖樣本數(shù)據(jù)集為圖二分類樣本數(shù)據(jù)集。

8、進一步地,所述采用語義后門檢測模塊檢測語義后門的步驟包括:

9、計算所述圖樣本數(shù)據(jù)集中每個圖樣本的每條邊對所述圖卷積神經(jīng)網(wǎng)絡模型預測結果的重要性分數(shù);

10、基于每條邊的重要性分數(shù),計算所述圖樣本數(shù)據(jù)集中每個圖樣本的每個節(jié)點對所述圖卷積神經(jīng)網(wǎng)絡模型預測結果的重要性分數(shù);

11、基于每個節(jié)點的重要性分數(shù),計算所述圖樣本數(shù)據(jù)集中每個圖樣本的每種節(jié)點標簽對所述圖卷積神經(jīng)網(wǎng)絡模型推理過程的重要性分數(shù);

12、基于每種節(jié)點標簽的重要性分數(shù),判斷所述圖卷積神經(jīng)網(wǎng)絡模型是否存在語義后門,完成檢測過程。

13、進一步地,采用積分梯度方法計算所述每條邊的重要性分數(shù),計算表達式為:

14、

15、式中,igi為第i條邊的重要性分數(shù),n表示從到x被劃分為n個路徑點,i表示各個向量的第i個分量,對應于輸入的圖樣本中的第i條邊,是模型在路徑點上的梯度,是基線,是一個一維向量,長度等于輸入的圖樣本中的邊的數(shù)量,值全為0,x是一個長度和相同的一維向量,x值全為1。

16、進一步地,采用加權的度中心性計算所述每個節(jié)點的重要性分數(shù),具體計算過程包括:

17、計算與節(jié)點相連的所有邊的重要性分數(shù)之和,再求平均,得到節(jié)點的重要性分數(shù),重復此過程,得到每個節(jié)點的重要性分數(shù)。

18、進一步地,所述得到每個節(jié)點的重要性分數(shù)后,還包括以下步驟:

19、對每個節(jié)點的重要性分數(shù)進行最小-最大歸一化,所述最小-最大歸一化的表達式為:

20、

21、式中,sscale為歸一化后的重要性分數(shù),s為原始的節(jié)點重要性分數(shù),min(s)、max(s)為原始的節(jié)點重要性分數(shù)中的最小值和最大值。

22、進一步地,所述每種節(jié)點標簽的重要性分數(shù)通過以下步驟計算得到:

23、將具有相同標簽的節(jié)點的重要性分數(shù)進行求和,再求平均,得到每種節(jié)點標簽的重要性分數(shù)。

24、進一步地,所述判斷所述圖卷積神經(jīng)網(wǎng)絡模型是否存在語義后門的步驟包括:

25、過濾掉所述圖樣本數(shù)據(jù)集中出現(xiàn)次數(shù)小于第一設定值的節(jié)點標簽;

26、對于剩余的節(jié)點標簽,根據(jù)每種節(jié)點標簽在兩個類別上的重要性分數(shù)來判斷是否存在語義后門,如果一種節(jié)點標簽在一個類別上的重要性分數(shù)高于第二設定值,并且在另一個類別上的重要性分數(shù)低于第三設定值,則表明在所述圖卷積神經(jīng)網(wǎng)絡模型中存在語義后門,若否,則表明不存在。

27、進一步地,所述識別出對應的語義觸發(fā)器和后門攻擊的目標類別的步驟包括:

28、將檢測出語義后門的節(jié)點標簽作為語義觸發(fā)器,其中重要性分數(shù)較高的類別作為后門攻擊的目標類別。

29、進一步地,所述得到不包含語義后門的圖卷積神經(jīng)網(wǎng)絡模型的步驟包括:

30、從所述圖樣本數(shù)據(jù)集挑選出包含所述語義觸發(fā)器且屬于目標類別的疑似后門樣本,并將其中部分疑似后門樣本的目標類別修改為非目標類別,構成新的圖樣本數(shù)據(jù)集;

31、將所述新的圖樣本數(shù)據(jù)集作為訓練數(shù)據(jù)集重新訓練所述圖卷積神經(jīng)網(wǎng)絡模型,以移除圖卷積神經(jīng)網(wǎng)絡模型中的語義后門,獲得不包含語義后門的圖卷積神經(jīng)網(wǎng)絡模型。

32、與現(xiàn)有技術相比,本發(fā)明具有以下有益效果:

33、(1)本發(fā)明能夠檢測并移除用于圖二分類任務的圖卷積神經(jīng)網(wǎng)絡模型中的語義后門,杜絕語義后門攻擊的安全威脅,保證圖卷積神經(jīng)網(wǎng)絡模型正常可靠地工作。

34、(2)本發(fā)明通過深入分析計算圖樣本數(shù)據(jù)集中每種節(jié)點標簽對圖卷積神經(jīng)網(wǎng)絡模型推理過程的貢獻,能夠檢測出圖卷積神經(jīng)網(wǎng)絡中隱藏的語義后門,并進一步識別出隱蔽的語義后門觸發(fā)器和后門攻擊的目標類別,然后以此為基礎,構建干凈訓練數(shù)據(jù)集,通過重新訓練的方法來移除圖卷積神經(jīng)網(wǎng)絡中的語義后門,有效解決了用于圖二分類任務的圖卷積神經(jīng)網(wǎng)絡的語義后門攻擊的防御問題。

- 還沒有人留言評論。精彩留言會獲得點贊!