一種基于深度圖輔助的多視圖語(yǔ)義識(shí)別方法

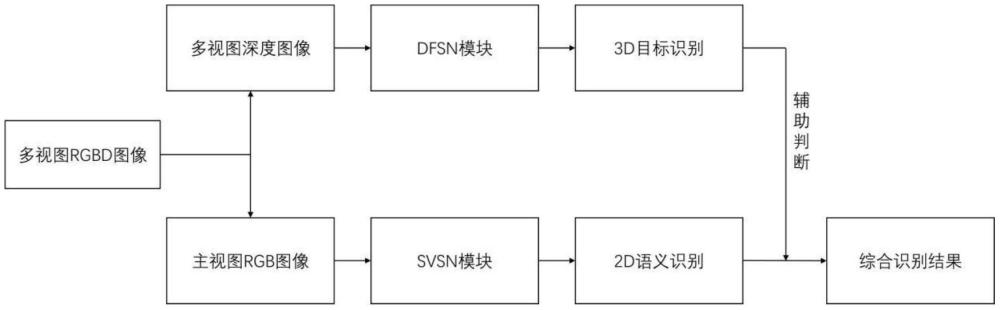

本發(fā)明屬于計(jì)算機(jī)視覺(jué)與深度學(xué)習(xí)領(lǐng)域,尤其是多視圖語(yǔ)義識(shí)別領(lǐng)域。具體而言,本發(fā)明涉及一種基于深度圖輔助的多視圖語(yǔ)義識(shí)別方法,該方法結(jié)合了深度融合語(yǔ)義網(wǎng)絡(luò)與單視圖語(yǔ)義網(wǎng)絡(luò)的網(wǎng)絡(luò)架構(gòu),實(shí)現(xiàn)了多視圖深度點(diǎn)云與主視圖rgb圖像的高效融合識(shí)別。

背景技術(shù):

1、隨著計(jì)算機(jī)視覺(jué)技術(shù)的發(fā)展,語(yǔ)義識(shí)別在自動(dòng)駕駛、無(wú)人機(jī)導(dǎo)航、增強(qiáng)現(xiàn)實(shí)(ar)等領(lǐng)域的應(yīng)用日益廣泛。語(yǔ)義識(shí)別的目標(biāo)是為場(chǎng)景中的每個(gè)像素賦予語(yǔ)義標(biāo)簽,如道路、車輛、行人等。傳統(tǒng)的語(yǔ)義識(shí)別方法通常依賴于單視圖的rgb圖像,但這種方法在處理復(fù)雜場(chǎng)景時(shí)常常面臨挑戰(zhàn)。例如,物體的遮擋、多視角間的視差、光照變化等因素,都會(huì)影響識(shí)別的準(zhǔn)確性。

2、為了解決這些問(wèn)題,研究者們提出了基于多視圖的語(yǔ)義識(shí)別方法,通過(guò)結(jié)合來(lái)自多個(gè)視角的信息,期望提高識(shí)別的魯棒性和準(zhǔn)確性。然而,多視圖方法需要處理大量的高維數(shù)據(jù),如何有效融合多視角信息仍然是一個(gè)挑戰(zhàn)。特別是當(dāng)涉及到融合來(lái)自不同模態(tài)的數(shù)據(jù),如rgb圖像和深度圖時(shí),傳統(tǒng)方法通常面臨以下幾個(gè)問(wèn)題:

3、特征對(duì)齊困難:多視圖之間存在視差,導(dǎo)致同一物體在不同視角下的表示不同。對(duì)于深度圖和rgb圖像,這種差異尤為明顯。如何在多視圖、多模態(tài)的數(shù)據(jù)中有效對(duì)齊特征,以實(shí)現(xiàn)有意義的融合,是一個(gè)關(guān)鍵問(wèn)題。

4、融合策略不完善:傳統(tǒng)方法大多采用簡(jiǎn)單的特征拼接或加權(quán)平均進(jìn)行模態(tài)融合,但這種方式難以充分發(fā)揮各模態(tài)數(shù)據(jù)的互補(bǔ)優(yōu)勢(shì),可能導(dǎo)致信息損失或冗余。

5、計(jì)算資源需求高:處理多視圖、多模態(tài)數(shù)據(jù)通常需要高計(jì)算資源,如何在保證識(shí)別精度的同時(shí),降低計(jì)算復(fù)雜度,也是一個(gè)重要的研究方向。

6、由此,近年來(lái),一些研究者提出了結(jié)合深度學(xué)習(xí)的多模態(tài)融合網(wǎng)絡(luò)。例如pointfusion使用點(diǎn)云與rgb圖像的特征,通過(guò)一個(gè)簡(jiǎn)單的連接層將兩者進(jìn)行融合,最終實(shí)現(xiàn)三維物體檢測(cè)。mv3d將點(diǎn)云投影到鳥(niǎo)瞰圖、前視圖等多個(gè)視角,并結(jié)合rgb圖像進(jìn)行多模態(tài)特征提取與融合,用于三維目標(biāo)檢測(cè)。frustum?pointnets通過(guò)圖像檢測(cè)框裁剪出對(duì)應(yīng)的點(diǎn)云分塊,利用pointnet處理裁剪點(diǎn)云實(shí)現(xiàn)3d目標(biāo)檢測(cè)。然而,這些網(wǎng)絡(luò)大多有特征對(duì)齊困難,對(duì)數(shù)據(jù)質(zhì)量依賴性強(qiáng),泛化能力不足等問(wèn)題。

7、綜上所述,傳統(tǒng)的多視圖語(yǔ)義識(shí)別方法在特征對(duì)齊、模態(tài)融合和計(jì)算復(fù)雜度方面存在顯著的挑戰(zhàn)。本發(fā)明旨在解決現(xiàn)有多視圖語(yǔ)義識(shí)別方法中存在的模態(tài)特征融合不充分、信息冗余與噪聲處理不足、深度信息稀疏性問(wèn)題,以及實(shí)時(shí)性與一致性建模不足等技術(shù)問(wèn)題。通過(guò)設(shè)計(jì)深度融合語(yǔ)義網(wǎng)絡(luò)(dfsn)和單視圖語(yǔ)義網(wǎng)絡(luò)(svsn),有效解決了這些問(wèn)題,實(shí)現(xiàn)了對(duì)多視圖、多模態(tài)數(shù)據(jù)的高效融合與高精度語(yǔ)義識(shí)別。dfsn負(fù)責(zé)處理多視角的深度點(diǎn)云與rgb圖像的融合,svsn則專注于主視圖rgb圖像的語(yǔ)義識(shí)別。最終的識(shí)別結(jié)果由這兩種網(wǎng)絡(luò)的輸出綜合而成,達(dá)到了更高的識(shí)別準(zhǔn)確性和魯棒性。

技術(shù)實(shí)現(xiàn)思路

1、針對(duì)現(xiàn)有技術(shù)中存在的不足,本發(fā)明提供了一種基于深度圖輔助的多視圖語(yǔ)義識(shí)別方法,該方法通過(guò)融合多視角的深度點(diǎn)云與主視圖的rgb圖像信息,實(shí)現(xiàn)高精度的語(yǔ)義識(shí)別。為了實(shí)現(xiàn)這一目標(biāo),本發(fā)明設(shè)計(jì)了一種包括兩個(gè)主要模塊的深度融合算法:深度融合語(yǔ)義網(wǎng)絡(luò)(dfsn,depth?fusion?semantic?network)模塊和單視圖語(yǔ)義網(wǎng)絡(luò)(svsn,singleview?semantic?network)模塊。

2、深度融合語(yǔ)義網(wǎng)絡(luò)(dfsn)是本發(fā)明中的核心網(wǎng)絡(luò)之一,專門用于處理多模態(tài)數(shù)據(jù)的融合。它接收多視角深度點(diǎn)云與主視圖rgb圖像,并通過(guò)以下步驟完成融合與識(shí)別:

3、多模態(tài)特征提取:dfsn首先對(duì)輸入的深度點(diǎn)云和rgb圖像進(jìn)行獨(dú)立的特征提取,使用卷積神經(jīng)網(wǎng)絡(luò)(cnn)分別提取深度點(diǎn)云和rgb圖像的空間特征和語(yǔ)義特征。

4、特征對(duì)齊:在多視角深度點(diǎn)云與主視圖rgb圖像的特征提取完成后,dfsn通過(guò)特征對(duì)齊模塊將這些特征在空間維度上進(jìn)行對(duì)齊。該模塊使用基于注意力機(jī)制的對(duì)齊算法,確保不同模態(tài)數(shù)據(jù)的特征在同一語(yǔ)義空間內(nèi)進(jìn)行有效融合。

5、特征融合:對(duì)齊后的特征在特征融合模塊中進(jìn)行融合。該模塊采用了改進(jìn)的特征融合策略,將深度特征與rgb特征進(jìn)行多層次、多尺度的融合,以增強(qiáng)模型對(duì)復(fù)雜場(chǎng)景中物體的識(shí)別能力。

6、語(yǔ)義解碼:融合后的特征通過(guò)語(yǔ)義解碼器生成多視角深度點(diǎn)云與rgb圖像的語(yǔ)義標(biāo)簽。dfsn在此過(guò)程中還結(jié)合了場(chǎng)景上下文信息,以提高對(duì)遮擋物和邊界區(qū)域的識(shí)別精度。

7、單視圖語(yǔ)義網(wǎng)絡(luò)(svsn)用于對(duì)主視圖rgb圖像進(jìn)行初步的語(yǔ)義識(shí)別。該網(wǎng)絡(luò)主要包括以下幾個(gè)模塊:

8、圖像特征提取:svsn采用深度卷積神經(jīng)網(wǎng)絡(luò)對(duì)輸入的rgb圖像進(jìn)行特征提取,生成一系列具有不同尺度的圖像特征。

9、多層次語(yǔ)義解碼:svsn通過(guò)多層次的語(yǔ)義解碼器對(duì)提取到的圖像特征進(jìn)行逐層解碼,輸出圖像中每個(gè)像素的語(yǔ)義標(biāo)簽。

10、注意力機(jī)制增強(qiáng):在特征解碼過(guò)程中,svsn集成了注意力機(jī)制,以增強(qiáng)對(duì)復(fù)雜場(chǎng)景中細(xì)小物體的識(shí)別能力,同時(shí)減少對(duì)背景噪聲的敏感度。

11、融合識(shí)別結(jié)果:在svsn和dfsn分別完成對(duì)rgb圖像和深度點(diǎn)云的識(shí)別后,語(yǔ)義融合模塊將這兩個(gè)識(shí)別結(jié)果進(jìn)行融合。融合模塊使用加權(quán)平均或基于規(guī)則的策略,結(jié)合svsn的單視圖識(shí)別結(jié)果和dfsn的多模態(tài)融合結(jié)果,生成最終的全局語(yǔ)義識(shí)別結(jié)果。這種融合策略不僅能夠提高識(shí)別的準(zhǔn)確性,還能夠在深度信息缺失或噪聲較大的情況下,利用rgb圖像的強(qiáng)語(yǔ)義信息進(jìn)行補(bǔ)充,增強(qiáng)語(yǔ)義融合模塊的魯棒性。

12、通過(guò)以上步驟,本發(fā)明的深度圖輔助多視圖語(yǔ)義識(shí)別方法有效地結(jié)合了多視角深度點(diǎn)云和主視圖rgb圖像的信息,實(shí)現(xiàn)了更高的識(shí)別精度和魯棒性。

13、一種基于深度圖輔助的多視圖語(yǔ)義識(shí)別方法,通過(guò)以下步驟實(shí)現(xiàn):

14、步驟1、多視角深度圖與主視圖rgb圖像的獲取。

15、從多臺(tái)攝像設(shè)備或傳感器獲取目標(biāo)場(chǎng)景的多視角深度圖和主視圖的rgb圖像。這些攝像設(shè)備可以同步捕捉同一場(chǎng)景的不同視角圖像和深度數(shù)據(jù)。將獲取的多視角深度圖數(shù)據(jù)進(jìn)行預(yù)處理,包括去噪、深度值歸一化等操作,以確保深度圖數(shù)據(jù)的質(zhì)量。選擇一個(gè)主視角的rgb圖像即主視圖作為單視圖語(yǔ)義識(shí)別的輸入圖像,主視圖應(yīng)具有最佳的視野、最少的遮擋,并能覆蓋場(chǎng)景中的主要目標(biāo)物體。

16、步驟2、深度點(diǎn)云的生成與處理。

17、將多視角深度圖轉(zhuǎn)換為多視角的深度點(diǎn)云數(shù)據(jù)。每個(gè)深度圖中的像素點(diǎn)根據(jù)其深度值被轉(zhuǎn)換為三維坐標(biāo)點(diǎn),形成點(diǎn)云數(shù)據(jù)。對(duì)生成的多視角深度點(diǎn)云進(jìn)行處理,包括點(diǎn)云對(duì)齊、降噪和稀疏化處理,以減少數(shù)據(jù)冗余和提高計(jì)算效率。對(duì)齊處理確保多視角點(diǎn)云在統(tǒng)一的坐標(biāo)系下表示,從而使不同視角的數(shù)據(jù)能夠進(jìn)行有效融合。將處理后的多視角深度點(diǎn)云數(shù)據(jù)作為深度融合語(yǔ)義網(wǎng)絡(luò)(dfsn)的輸入之一。

18、步驟3、單視圖rgb圖像的語(yǔ)義識(shí)別。

19、將主視角的rgb圖像輸入單視圖語(yǔ)義網(wǎng)絡(luò)(svsn)。svsn采用深度卷積神經(jīng)網(wǎng)絡(luò)(cnn)架構(gòu),首先對(duì)rgb圖像進(jìn)行特征提取。卷積層捕捉圖像的空間結(jié)構(gòu)特征,多尺度特征提取層捕捉圖像中的細(xì)節(jié)信息。然后svsn通過(guò)多層次語(yǔ)義解碼器對(duì)提取到的特征進(jìn)行逐層解碼,生成初步的語(yǔ)義標(biāo)簽圖。解碼過(guò)程中,注意力機(jī)制用于動(dòng)態(tài)關(guān)注圖像中的關(guān)鍵區(qū)域,增強(qiáng)對(duì)重要目標(biāo)物的識(shí)別能力。將svsn的輸出語(yǔ)義標(biāo)簽圖存儲(chǔ),作為最終融合結(jié)果的輸入之一。

20、步驟4、深度融合語(yǔ)義識(shí)別。

21、將預(yù)處理后的多視角深度點(diǎn)云與主視角的rgb圖像一起輸入深度融合語(yǔ)義網(wǎng)絡(luò)(dfsn)。dfsn首先分別對(duì)深度點(diǎn)云和rgb圖像進(jìn)行獨(dú)立的特征提取。然后對(duì)提取的深度點(diǎn)云和rgb圖像特征進(jìn)行特征對(duì)齊,dfsn使用基于注意力機(jī)制的特征對(duì)齊算法,確保不同模態(tài)的特征能夠在同一語(yǔ)義空間內(nèi)進(jìn)行對(duì)齊。對(duì)齊過(guò)程考慮了視差補(bǔ)償、特征旋轉(zhuǎn)和縮放等操作,以克服多視角間的視差影響。

22、將對(duì)齊后的特征送入特征融合模塊進(jìn)行融合。該模塊采用自適應(yīng)特征融合策略,動(dòng)態(tài)調(diào)整rgb圖像特征和深度點(diǎn)云特征的權(quán)重,以充分發(fā)揮各自的優(yōu)勢(shì)。融合后的特征更加魯棒,能夠更好地處理復(fù)雜的場(chǎng)景和遮擋情況。

23、將特征融合模塊輸出的融合特征輸入語(yǔ)義解碼器生成融合后的語(yǔ)義標(biāo)簽圖,該標(biāo)簽圖綜合了多視角深度點(diǎn)云與主視圖rgb圖像的信息,識(shí)別精度高于單模態(tài)方法。

24、步驟5、語(yǔ)義識(shí)別結(jié)果的融合。

25、通過(guò)語(yǔ)義融合模塊綜合單視圖語(yǔ)義網(wǎng)絡(luò)(svsn)和深度融合語(yǔ)義網(wǎng)絡(luò)(dfsn)的輸出結(jié)果。語(yǔ)義融合模塊采用加權(quán)平均結(jié)合基于規(guī)則的融合策略,將兩種網(wǎng)絡(luò)的語(yǔ)義識(shí)別結(jié)果進(jìn)行組合。具體融合策略為:正常情況下最終預(yù)測(cè)結(jié)果為兩種網(wǎng)絡(luò)的語(yǔ)義識(shí)別結(jié)果的加權(quán)平均結(jié)果。但在輸入數(shù)據(jù)缺失,產(chǎn)生遮擋或光線反射的情況下,語(yǔ)義融合模塊將根據(jù)不同情況對(duì)預(yù)測(cè)結(jié)果進(jìn)行修正,從而提高最終識(shí)別的可靠性。生成最終的語(yǔ)義識(shí)別結(jié)果。該結(jié)果結(jié)合了多視角、多模態(tài)信息,具有高魯棒性和精度,可應(yīng)用于自動(dòng)駕駛、機(jī)器人導(dǎo)航等領(lǐng)域。

26、步驟6、輸出與應(yīng)用。

27、將最終生成的語(yǔ)義識(shí)別結(jié)果以圖像或三維模型的形式輸出,用于后續(xù)的分析、處理或決策。該結(jié)果可以用于自動(dòng)駕駛系統(tǒng)中的實(shí)時(shí)環(huán)境感知、無(wú)人機(jī)導(dǎo)航系統(tǒng)中的障礙物檢測(cè)、智能監(jiān)控系統(tǒng)中的目標(biāo)跟蹤等應(yīng)用場(chǎng)景。

28、通過(guò)以上步驟,本發(fā)明提供的深度圖輔助多視圖語(yǔ)義識(shí)別方法有效地解決了傳統(tǒng)方法在處理復(fù)雜場(chǎng)景、多視圖融合以及深度圖和rgb圖像結(jié)合時(shí)的難題,具有較高的識(shí)別精度和適用性。

29、本發(fā)明有益效果如下:

30、本發(fā)明在現(xiàn)有技術(shù)基礎(chǔ)上,通過(guò)結(jié)合多視圖深度點(diǎn)云和主視圖rgb圖像,設(shè)計(jì)了一種基于深度學(xué)習(xí)的多模態(tài)融合網(wǎng)絡(luò),顯著提升了多視圖語(yǔ)義識(shí)別的準(zhǔn)確性和魯棒性。相比于傳統(tǒng)方法僅依賴單一模態(tài)的信息,本發(fā)明利用深度點(diǎn)云捕獲三維幾何結(jié)構(gòu)信息,同時(shí)通過(guò)rgb圖像提取豐富的紋理和語(yǔ)義特征,并在語(yǔ)義融合階段引入加權(quán)平均結(jié)合基于規(guī)則的動(dòng)態(tài)調(diào)整策略,從而有效解決了傳統(tǒng)方法在復(fù)雜場(chǎng)景下易受光照變化、遮擋和噪聲干擾的問(wèn)題。本發(fā)明不僅提高了語(yǔ)義識(shí)別的全面性和精確性,還增強(qiáng)了模型應(yīng)對(duì)多模態(tài)數(shù)據(jù)不一致和輸入異常情況的能力,具有廣泛的應(yīng)用前景。

- 還沒(méi)有人留言評(píng)論。精彩留言會(huì)獲得點(diǎn)贊!