一種基于雷達數據的多車協同3D目標檢測方法及系統

本發明涉及智能交通,尤其涉及一種基于雷達數據的多車協同3d目標檢測方法及系統。

背景技術:

1、隨著自動駕駛技術的逐步成熟,車輛的環境感知能力已成為保證自動駕駛安全和提升駕駛效率的關鍵因素之一。雷達,尤其是毫米波雷達,因其全天候、全天時的穩定工作能力,廣泛應用于自動駕駛系統中。雷達能夠在惡劣的天氣條件下(如霧霾、雨雪等)穩定工作,相較于激光雷達和攝像頭,具有更好的穿透能力,因此,在復雜道路和環境中的應用表現尤為突出。

2、盡管單車雷達系統具有較強的環境感知能力,但其仍然存在許多局限性。單車雷達由于其視野范圍和探測距離的限制,往往難以有效感知遠離自身的物體或被遮擋的目標。此外,單車雷達的感知結果僅局限于單車自身的視角,無法獲取其他車輛的環境信息。這使得單車雷達在復雜交通環境下,特別是動態交通流中,難以做出準確的目標識別和定位。更為嚴重的是,單車雷達的精度通常依賴于傳感器的質量和環境條件,在惡劣天氣或多障礙物的復雜環境中,誤檢和漏檢的現象較為常見,嚴重影響自動駕駛系統的安全性和可靠性。

3、為了克服單車雷達系統的局限性,多車協同系統應運而生。在多車協同環境下,通過車輛間的實時數據共享,各車不僅能夠感知自身周圍的環境,還能將其他車輛的雷達數據融合起來,從而獲得更廣泛、全面的環境感知信息。這種多車協同的方式,能夠有效提升目標檢測的精度、減少盲區、增強系統的魯棒性。然而,盡管多車協同系統為解決單車雷達的局限性提供了新的思路,但多車協同雷達數據的處理面臨著一系列的挑戰,尤其是位置誤差和時間延遲問題,具體問題如下:

4、1.位置誤差問題,在多車協同系統中,雷達數據的共享需要依賴車載通信系統將來自不同車輛的雷達數據進行融合。然而,由于每輛車的位置、速度、朝向不同,且車輛之間的相對位置經常發生變化,如何精確對齊不同車輛的雷達數據,確保數據的空間一致性,成為了多車協同系統中一個核心的技術難題。尤其在車輛高速行駛或急劇轉彎的情況下,車輛間的相對位置變化較快,若無法準確同步不同車輛的雷達數據,可能會引入較大的位置誤差,這將直接影響目標檢測的準確性和魯棒性。

5、2.時間延遲問題,時間延遲是多車協同系統中另一項關鍵問題。在多車協同環境下,車輛間的雷達數據通常需要通過車載通信系統進行實時共享,這種數據傳輸會受到網絡帶寬、信號延遲、通信協議等多方面因素的影響。特別是在高速行駛或復雜的交通環境中,數據傳輸的延遲往往難以避免,這會導致不同車輛的數據同步不準確,從而影響整個系統對目標的檢測和判斷。例如,當某輛車的雷達探測到前方障礙物時,由于通信延遲,其他車輛可能需要幾百毫秒甚至更長的時間才能接收到該信息。這一延遲在動態交通環境中,尤其是在快速變化的場景中,可能導致其他車輛的環境感知數據滯后,進而影響目標的及時定位和避讓決策。

技術實現思路

1、本發明實施例的主要目的在于提出一種基于雷達數據的多車協同3d目標檢測方法及系統,能夠提高目標檢測的精度和魯棒性,使得自動駕駛系統在動態、復雜的路況中能夠實時、精準地識別目標,增強了自動駕駛系統的安全性。

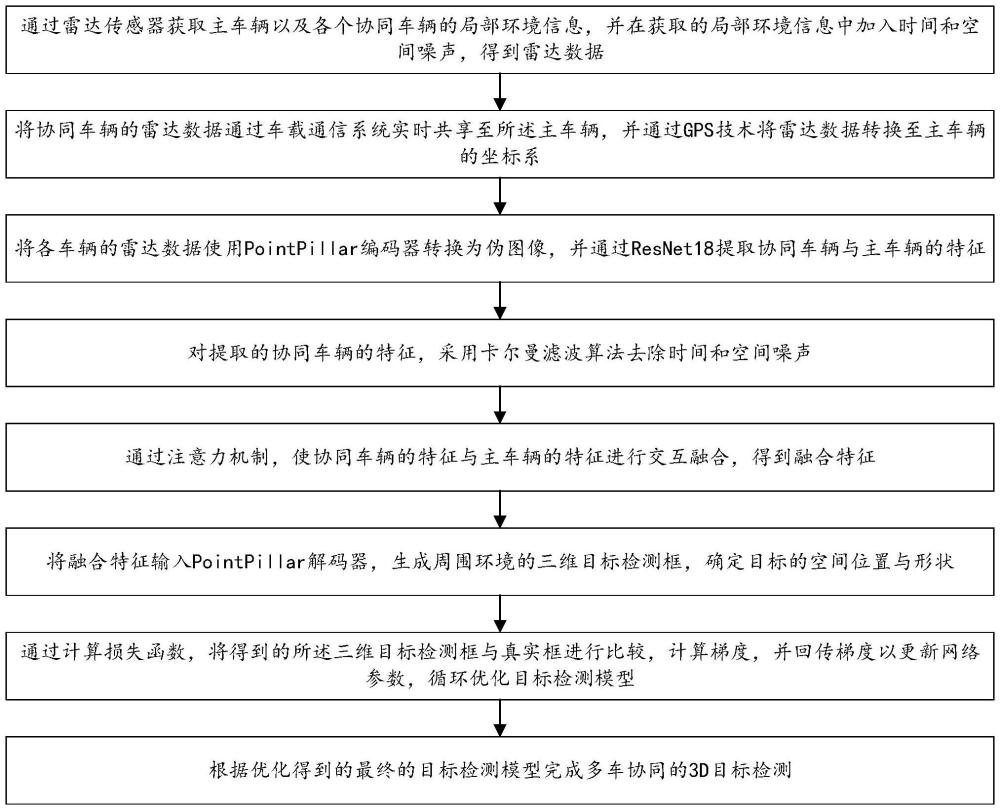

2、為實現上述目的,本發明實施例的一方面提出了一種基于雷達數據的多車協同3d目標檢測方法,包括以下步驟:

3、通過雷達傳感器獲取主車輛以及各個協同車輛的局部環境信息,并在獲取的局部環境信息中加入時間和空間噪聲,得到雷達數據;

4、將協同車輛的雷達數據通過車載通信系統實時共享至所述主車輛,并通過gps技術將雷達數據轉換至主車輛的坐標系;

5、將各車輛的雷達數據使用pointpillar編碼器轉換為偽圖像,并通過resnet18提取協同車輛與主車輛的特征;

6、對提取的協同車輛的特征,采用卡爾曼濾波算法去除時間和空間噪聲;

7、通過注意力機制,使協同車輛的特征與主車輛的特征進行交互融合,得到融合特征;

8、將融合特征輸入pointpillar解碼器,生成周圍環境的三維目標檢測框,確定目標的空間位置與形狀;

9、通過計算損失函數,將得到的所述三維目標檢測框與真實框進行比較,計算梯度,并回傳梯度以更新網絡參數,循環優化目標檢測模型;

10、根據優化得到的最終的目標檢測模型完成多車協同的3d目標檢測。

11、在一些實施例中,所述將協同車輛的雷達數據通過車載通信系統實時共享至所述主車輛,并通過gps技術將雷達數據轉換至主車輛的坐標系,包括以下步驟:

12、將局部坐標系映射至世界坐標系,根據從車的gps信息獲取位置信息和姿態信息,所述姿態信息包括俯仰角α、偏航角β和滾轉角γ;

13、構建旋轉矩陣r和車輛在世界坐標系中的平移向量t,以描述局部坐標系相對于世界坐標系的旋轉和平移方式;

14、利用線性變換公式計算得到世界坐標系的三維點云特征,具體計算公式為:pworld=r·plocal+t,其中,pworld為世界坐標系的三維點云特征;plocal為局部坐標系的三維點云特征;

15、將世界坐標系歸一化變換至主車坐標系,通過主車和從車的位置信息計算相對平移以及兩車的相對旋轉矩陣;

16、將世界坐標系下的點云數據投影至主車坐標系,具體公式為:其中,pmain主車坐標系的三維點云特征;rrelative為兩車的相對旋轉矩陣;t2為主車輛在世界坐標系中的平移向量。

17、在一些實施例中,所述將各車輛的雷達數據使用pointpillar編碼器轉換為偽圖像,并通過resnet18提取協同車輛與主車輛的特征,包括以下步驟:

18、將點云數據按俯視圖坐標系劃分為規則的柱狀體;

19、每個點的初始特征包括點的三維位置、反射強度;

20、計算每個點相對于柱狀體中心的相對位置和相對于網格原點的相對位置,形成點特征向量;點特征向量fpoint的計算公式為:fpoint=[x,y,z,i,xrel,yrel,zrel],其中,x,y,z代表點的三維位置;i代表反射強度;xrel,yrel,zrel是點相對于其柱狀體中心的相對坐標;

21、采用點云特征提取網絡處理每個點特征,對屬于同一柱狀體的點特征進行聚合;

22、通過最大池化或平均池化生成柱狀體級別的特征,得到每個柱狀體對應一個固定維度的特征向量fpillar。

23、在一些實施例中,所述對提取的協同車輛的特征,采用卡爾曼濾波算法去除時間和空間噪聲,包括以下步驟:

24、在每次時刻k的目標狀態預測中,首先根據系統的狀態轉移模型和控制輸入進行預測,預測過程的表達式為:其中,是時刻k的預測狀態,a是狀態轉移矩陣,是上一時刻的更新狀態,b是控制輸入矩陣,uk-1是控制輸入;

25、對系統的協方差進行預測更新,該過程的表達式為:pk|k-1=apk-1|k-1at+q,其中,pk|k-1表示時刻k的預測協方差,q為過程噪聲協方差,表示模型中未建模部分的變化;

26、在每次時刻k獲得新觀測zk后,卡爾曼濾波通過計算卡爾曼增益來融合預測狀態和實際觀測,從而得到更新后的狀態估計,其中,卡爾曼增益的計算公式為:kk=pk|k-1ht(hpk|k-1ht+r)-1,其中,kk為卡爾曼增益,h為觀測矩陣,r為觀測噪聲協方差;

27、更新后的目標狀態估計表示為:其中,為更新后的目標狀態,zk為當前時刻的實際觀測值;

28、根據卡爾曼增益更新協方差矩陣,更新過程的表達式為:pk|k=(i-kkh)pk|k-1,其中,pk|k為更新后的協方差矩陣,i為單位矩陣。

29、在一些實施例中,所述通過注意力機制,使協同車輛的特征與主車輛的特征進行交互融合,得到融合特征,包括以下步驟:

30、輸入數據x∈rn×d通過線性變換映射為查詢query矩陣q、鍵key矩陣k、值value矩陣v:

31、q=xwq,k=xwk,v=xwv;

32、其中,分別為查詢、鍵和值的線性變換矩陣,dk和dv為查詢、鍵和值的維度;

33、采用softmax歸一化操作,計算注意力權重,注意力權重attentionweights的計算公式為:

34、得到加權求和后的注意力輸出,使協同車輛的特征與主車輛的特征進行交互融合,得到融合特征。

35、在一些實施例中,所述將融合特征輸入pointpillar解碼器,生成周圍環境的三維目標檢測框,確定目標的空間位置與形狀,包括以下步驟:

36、所述pointpillar解碼器用于將融合后的特征信息轉換為三維目標檢測框,三維目標檢測框表示環境中的目標物體的位置、大小、形態;

37、根據所述三維目標檢測框生成目標的三維坐標及方向信息;

38、pointpillar解碼器在處理雷達數據時,將多車協同得到的特征映射到三維空間,生成目標的三維邊界框,確定目標的空間位置與形狀。

39、在一些實施例中,所述損失函數用于計算預測的3d目標檢測框與真實框之間的差異,并通過反向傳播機制更新網絡參數,優化目標檢測精度;

40、損失函數l的公式為:

41、l=∑(λ1*l1(xi,x′i)+λ2*l2(yi,y′i)+λ3*l3(zi,z′i))

42、其中,l1,l2,l3分別表示對目標的位置、大小和方向的誤差計算;x′i,y′i,z′i為預測框的位置信息;xi,yi,zi為真實框的位置信息;λ1,λ2,λ3為權重系數,用于平衡不同類別的損失。

43、本發明實施例的另一方面還提供了一種基于雷達數據的多車協同3d目標檢測系統,包括:

44、第一模塊,用于通過雷達傳感器獲取主車輛以及各個協同車輛的局部環境信息,并在獲取的局部環境信息中加入時間和空間噪聲,得到雷達數據;

45、第二模塊,用于將協同車輛的雷達數據通過車載通信系統實時共享至所述主車輛,并通過gps技術將雷達數據轉換至主車輛的坐標系;

46、第三模塊,用于將各車輛的雷達數據使用pointpi?l?l?ar編碼器轉換為偽圖像,并通過resnet18提取協同車輛與主車輛的特征;

47、第四模塊,用于對提取的協同車輛的特征,采用卡爾曼濾波算法去除時間和空間噪聲;

48、第五模塊,用于通過注意力機制,使協同車輛的特征與主車輛的特征進行交互融合,得到融合特征;

49、第六模塊,用于將融合特征輸入pointpi?l?l?ar解碼器,生成周圍環境的三維目標檢測框,確定目標的空間位置與形狀;

50、第七模塊,用于通過計算損失函數,將得到的所述三維目標檢測框與真實框進行比較,計算梯度,并回傳梯度以更新網絡參數,循環優化目標檢測模型;

51、第八模塊,用于根據優化得到的最終的目標檢測模型完成多車協同的3d目標檢測。

52、為實現上述目的,本發明實施例的另一方面提出了一種電子設備,所述電子設備包括存儲器和處理器,所述存儲器存儲有計算機程序,所述處理器執行所述計算機程序時實現前面所述的方法。

53、為實現上述目的,本發明實施例的另一方面提出了一種計算機可讀存儲介質,所述計算機可讀存儲介質存儲有計算機程序,所述計算機程序被處理器執行時實現前面所述的方法。

54、本發明實施例還公開了一種計算機程序產品或計算機程序,該計算機程序產品或計算機程序包括計算機指令,該計算機指令存儲在計算機可讀存儲介質中。計算機設備的處理器可以從計算機可讀存儲介質讀取該計算機指令,處理器執行該計算機指令,使得該計算機設備執行前面的方法。

55、本發明實施例至少包括以下有益效果:本發明提供一種基于雷達數據的多車協同3d目標檢測方法及系統,該方案通過雷達傳感器獲取主車輛以及各個協同車輛的局部環境信息,并在獲取的局部環境信息中加入時間和空間噪聲,得到雷達數據;將協同車輛的雷達數據通過車載通信系統實時共享至所述主車輛,并通過gps技術將雷達數據轉換至主車輛的坐標系;將各車輛的雷達數據使用pointpi?l?l?ar編碼器轉換為偽圖像,并通過resnet18提取協同車輛與主車輛的特征;對提取的協同車輛的特征,采用卡爾曼濾波算法去除時間和空間噪聲;通過注意力機制,使協同車輛的特征與主車輛的特征進行交互融合,得到融合特征;將融合特征輸入pointpi?l?l?ar解碼器,生成周圍環境的三維目標檢測框,確定目標的空間位置與形狀;通過計算損失函數,將得到的所述三維目標檢測框與真實框進行比較,計算梯度,并回傳梯度以更新網絡參數,循環優化目標檢測模型;根據優化得到的最終的目標檢測模型完成多車協同的3d目標檢測。本發明實施例能夠提高目標檢測的精度和魯棒性,使得自動駕駛系統在動態、復雜的路況中能夠實時、精準地識別目標,增強了自動駕駛系統的安全性。

- 還沒有人留言評論。精彩留言會獲得點贊!