基于強化學習的多智能體固定時間最優一致性算法

本發明涉及多智能體控制,尤其專注于基于強化學習的多智能體固定時間最優一致性控制方法。

背景技術:

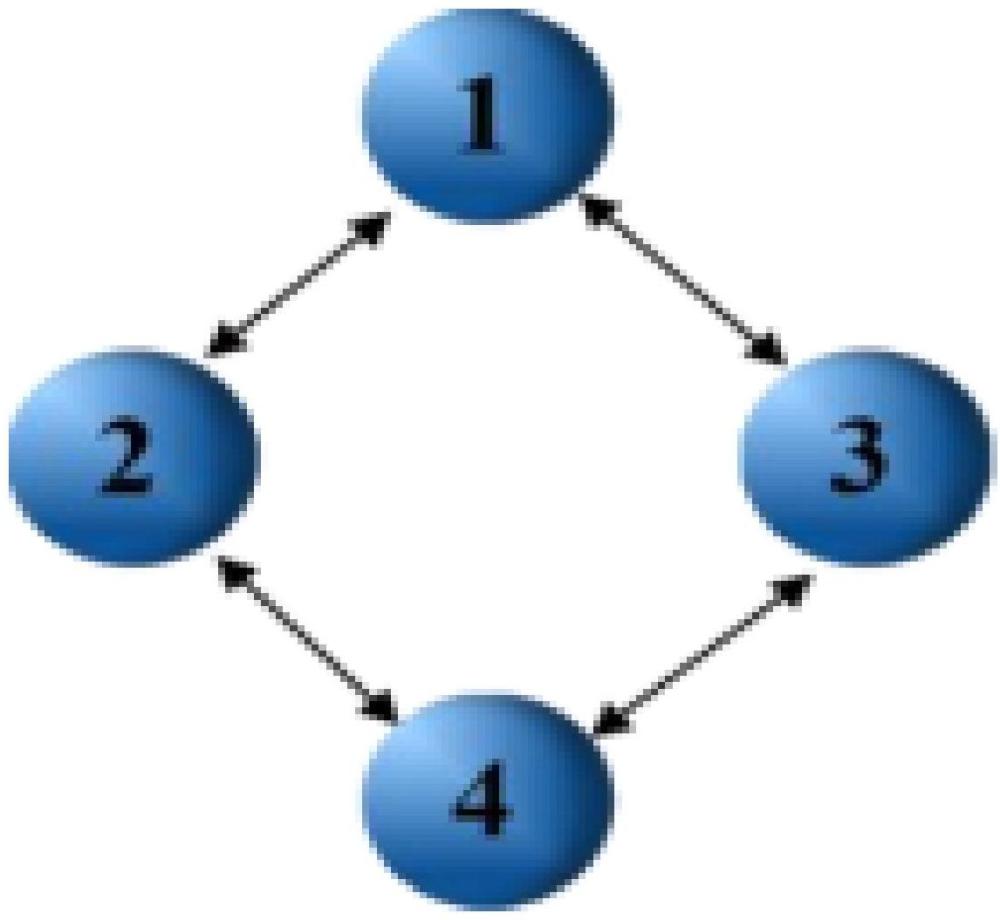

1、隨著科技發展,多智能體系統在智能交通、智能電網、機器人協作、無人機集群控制等諸多領域展現出巨大應用潛力。然而,多智能體系統在實際應用中面臨諸多挑戰。

2、多智能體系統的動力學模型通常較為復雜,包含大量非線性因素。例如,在機器人協作場景中,機器人運動受自身機械結構、環境摩擦力和負載變化等多種非線性因素影響。并且,在許多情況下,系統存在未知部分,使得精確建立系統模型極為困難,傳統基于模型的控制方法在面對此類復雜未知系統時有效性受限。

3、多智能體系統中智能體需通信協調行為。傳統的時間觸發通信方式下,智能體按固定時間間隔交互信息。但當系統狀態變化緩慢時,頻繁通信雖無更多有價值信息,卻消耗大量通信資源和能量。如大規模智能電網系統中,眾多分布式能源資源和智能電表等設備采用時間觸發通信,會產生大量通信數據,加重系統負擔,降低運行效率。

4、為提高多智能體系統性能和效率,需一種能處理系統未知部分且減少通信損耗的控制方法。強化學習無需精確系統模型即可學習最優控制策略,為解決多智能體系統控制問題提供新思路。同時,滿足實際應用對系統收斂速度要求,實現固定時間內的最優一致性控制成為研究重點,有助于系統在規定時間內達到理想協作狀態,提升整體性能和可靠性。

技術實現思路

1、本發明涉及多智能體控制技術領域,尤其專注于基于強化學習的多智能體固定時間最優一致性控制方法。

2、為了實現上述目的,本發明采用如下的技術方案:

3、1.一種基于強化學習的多智能體固定時間最優一致性控制方法,其特征在于,包括以下步驟:

4、s1:明確多智能體系統的動力學模型,所述模型包含n個智能體,第i個智能體的動力學模型為

5、xi=fi(x1i,x2i)+biui

6、其中xi(t)∈rn,ui(t)∈rn,fi(xi(t))∈rn分別表示智能體的狀態、控制輸入和可能存在未知的非線性函數。其中,輸入的幅值受到限制‖ui‖≤δi,已知δi為輸入的上界。

7、s2:利用強化學習技術,通過系統的輸入輸出數據來近似求解最優控制策略。在此過程中,使用積分強化學習方法更新神經網絡權重,使神經網絡能夠適應系統的未知特性,并使系統逐漸收斂到最優控制策略。

8、s3:設計雙事件觸發函數,分別控制系統的通信和控制。當滿足觸發條件時進行通信和狀態更新,減少通信與控制資源損耗。

9、s4:將上述未知模型辨識策略、新型控制算法通過編程灌入各個多智能體中,使其能夠按照設計的規則運行。

10、與現有技術相比,本發明具有以下顯著優點:

11、本發明的兩大創新點提升了多智能體系統的控制效率和性能。首先,提出了一種基于強化學習的固定時間最優一致性控制算法,該算法通過actor和critic神經網絡的交互迭代,逼近最優控制策略,無需精確系統模型即可學習控制策略。其次,引入了事件觸發機制,減少了通信資源損耗,提高了系統運行效率。通過設計最優跟蹤算法和事件觸發函數,本發明確保了系統在滿足一致性的同時達到最優性能,適用于多智能體系統的固定時間最優一致性控制。

技術特征:

1.一種基于強化學習的多智能體固定時間最優一致性方法,其特征在于,包括以下步驟:

2.根據權利要求1所述的一種基于強化學習的多智能體固定時間最優一致性控制方法,其特征在于,在s1中:

3.根據權利要求1所述的一種基于強化學習的多智能體固定時間最優一致性控制方法,其特征在于,在s2中:

4.基于bellman誤差定義目標函數使用梯度下降法,根據相應公式得到critic神經網絡的更新率:

5.根據權利要求1所述的一種基于強化學習的多智能體固定時間最優一致性控制方法,其特征在于,在s3中:

6.設計事件觸發機制,在輔助系統的基礎上通過合理定義事件觸發函數,基于定義目標函數,使用梯度下降法將critic神經網絡的更新率設計為:

7.根據權利要求1所述的一種基于強化學習的多智能體固定時間最優一致性控制方法,其特征在于,在s4中:

技術總結

本發明提供了一種基于強化學習的多智能體固定時間最優一致性控制方法,涉及多智能體控制技術領域。該方法包括確定多智能體系統動力學模型、通過強化學習近似求解最優控制、設計雙事件觸發函數減少通信損耗,并將控制算法灌入多智能體中。本發明通過actor神經網絡和critic神經網絡的交互迭代,逼近最優控制策略,無需精確系統模型即可學習控制策略,有效減少通信資源損耗,提高系統運行效率。實現了固定時間內的最優一致性控制,提升了系統性能和可靠性。本發明適用于智能交通、智能電網、機器人協作和無人機集群控制等領域,滿足實際應用對系統收斂速度的要求。

技術研發人員:唐文妍,孫笑宇,吳佳,何欣然,周彥

受保護的技術使用者:湘潭大學

技術研發日:

技術公布日:2025/4/24

- 還沒有人留言評論。精彩留言會獲得點贊!