一種自強化的動態知識蒸餾方法

本發明涉及機器學習領域,具體講是涉及通過知識蒸餾將教師模型中的知識傳遞給學生模型,以此增強學生性能的一種模型壓縮方法。

背景技術:

1、隨著計算機硬件性能的不斷提升和深度學習算法的飛速發展,深度學習技術已經成為處理圖像分類、目標檢測、語義分割等多種機器學習任務的主流方法。在圖像分類方面,深度學習技術能夠在各種復雜場景下準確地將圖像歸類到不同的類別。這一成就歸功于卷積神經網絡能夠進行層次化的特征提取,逐步學習圖像中的復雜特征和細節,從而實現對物體類別的高效識別。然而,這種高度的抽象能力和特征提取過程需要大量的模型參數來確保其準確性。此外,訓練大型卷積神經網絡還需要強大的計算資源和充足的存儲空間,以支持模型訓練的復雜度和規模。然而,在實際應用中,尤其是在資源受限的環境下,如嵌入式系統、移動設備或邊緣計算節點,大型卷積神經網絡模型面臨著部署困難。移動設備的處理能力有限,嵌入式系統只有有限的計算資源,而邊緣計算節點則需要在分布式環境下處理大量的實時數據。這些限制都要求模型在部署過程中進行優化和壓縮,以適應有限的計算資源和存儲容量。

2、研究者們提出了模型優化的多種技術。一方面,他們致力于開發輕量級模型結構,如深度可分離卷積網絡、稀疏卷積網絡和緊湊型神經網絡等,通過減少模型中的參數量和計算復雜度,來提高模型在嵌入式和移動設備上的運行效率。另一方面,研究者們還在探索一系列新的算法和技術,旨在進一步優化模型。例如,通過模型量化技術降低模型中數值表示的精度來減少模型的存儲需求和計算資源消耗。通過網絡剪枝技術移除不重要的神經元和連接來簡化模型結構。盡管這些技術可以簡化模型,但通常會犧牲模型的整體性能。知識蒸餾則是將一個復雜的大模型中的知識傳授給輕量級的模型,因此,它能夠在壓縮模型參數的同時保持模型的整體性能。此外,知識蒸餾可以應用于幾乎所有類型的網絡結構,并能夠與其他優化技術無縫集成,具備很好的簡便性和實用性。

3、本發明設計一種自強化的動態知識蒸餾方法,讓在學生模型學習標簽知識時引入自強化技術,使學生模型對所學的內容進行及時復習,避免知識遺忘,進一步提升其性能表現。

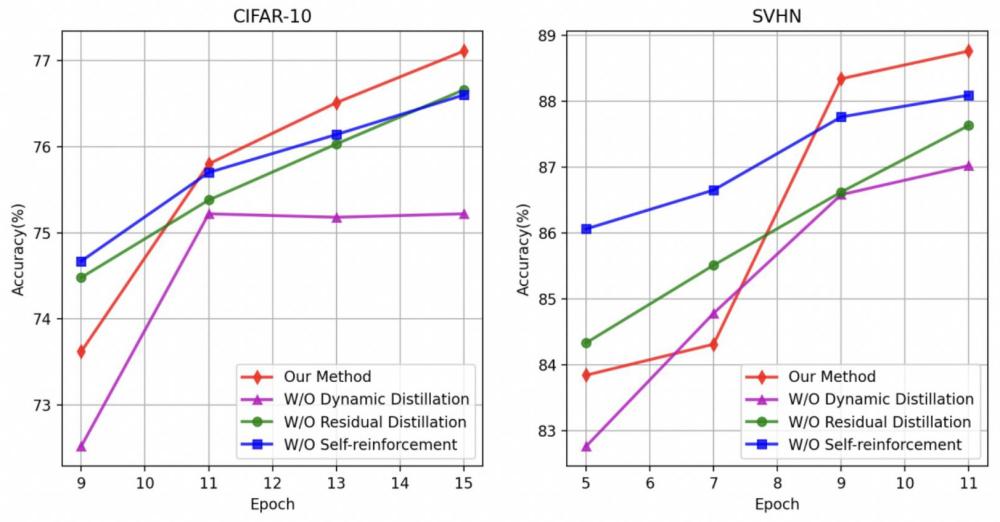

4、本發明在cifar-10數據集和svhn兩個數據集上對自強化的動態知識蒸餾方法的有效性進行了驗證,結果表明,在師生同構的實驗設置下,本文方案訓練的學生模型在cifar-10數據集上達到了77.11%的準確度,在svhn數據集上達到了88.76%的準確度。因此,本文發明的方案展現了卓越的表現,為各種應用場景下的模型壓縮提供了強有力的支持。

技術實現思路

1、本發明設計了一種自強化的動態知識蒸餾方法,該方法在學生模型計算預測結果與真實標簽之間的距離時,同時計算深層特征圖與淺層特征圖之間的距離,從而在學習新知識的過程中避免遺忘淺層特征中的重要知識,提升學生模型的學習性能。

2、一種自強化的動態知識蒸餾方法,包括兩個部分:對特征進行動態蒸餾和對學習效果進行自強化。

3、(1)對特征進行動態蒸餾

4、特征圖是模型在處理輸入數據時生成的中間層表示,深刻反映了模型捕捉數據特征的能力。通過對比學生模型與教師模型之間特征圖的差異,能夠有效評估學生模型的特征提取能力。

5、本發明對特征進行動態蒸餾:首先設定一個損失閾值,并計算學生模型特征圖與教師模型特征圖之間的距離。當兩者的距離小于設定的閾值時,說明學生模型的特征圖與教師模型的特征圖差距較小,學生模型的特征提取能力已接近教師模型,無需繼續學習教師模型的特征圖知識。當兩者的距離大于設定的閾值時,表明學生模型的特征圖與教師模型的特征圖差距較大,此時學生模型的特征提取能力較弱,需要繼續學習教師模型的特征圖知識,進一步提升其特征提取能力。

6、(2)對學習效果進行自強化

7、在學生模型學習標簽知識時引入自強化技術,使學生模型對所學的內容進行及時復習,避免知識遺忘,進一步提升其性能表現。

8、在學生模型計算預測結果與真實標簽之間的距離時,同時計算深層特征圖與淺層特征圖之間的距離,從而在學習新知識的過程中避免遺忘淺層特征中的重要知識,對學習效果進行自強化。

技術特征:

1.一種自強化的動態知識蒸餾方法,特征在于:

技術總結

本發明涉及機器學習領域,具體講是涉及通過知識蒸餾是將教師模型中的知識傳遞給學生模型,以此增強學生性能的一種模型壓縮方法。本發明設計一種自強化的動態知識蒸餾方法,讓在學生模型學習標簽知識時引入自強化技術,使學生模型對所學的內容進行及時復習,避免知識遺忘,進一步提升其性能表現。從而得到一種更優的模型壓縮方法,使得機器學習可以更好地應用于在資源受限的環境和應用于處理能力有限的移動設備。

技術研發人員:請求不公布姓名,請求不公布姓名,請求不公布姓名

受保護的技術使用者:濟寧醫學院

技術研發日:

技術公布日:2025/4/28

- 還沒有人留言評論。精彩留言會獲得點贊!