一種黃斑變性分類系統(tǒng)的構(gòu)建方法及黃斑變性分類系統(tǒng)

本發(fā)明涉及圖像分類,具體涉及一種黃斑變性分類系統(tǒng)的構(gòu)建方法及黃斑變性分類系統(tǒng)。

背景技術(shù):

1、年齡相關(guān)性黃斑變性(amd)是一種在老年人群中高發(fā)的視網(wǎng)膜退行性疾病,也是全球范圍內(nèi)導(dǎo)致不可逆性視力喪失的主要原因之一。根據(jù)病理特征和疾病進展,amd可以進一步分為干性amd、濕性amd以及息肉樣脈絡(luò)膜血管病變(pcv),鑒于這些亞型在治療方法上存在差異,精確區(qū)分正常視網(wǎng)膜與不同的amd亞型對于制定個性化治療策略和改善患者預(yù)后具有重要臨床意義。在amd的診斷中,彩色眼底照相(cfp)和光學(xué)相干斷層掃描(oct)是兩種常用的無創(chuàng)眼底成像技術(shù)。cfp能夠提供視網(wǎng)膜表面的高分辨率彩色圖像,有助于檢測表面異常,但對視網(wǎng)膜深層結(jié)構(gòu)的變化識別能力有限;而oct則可詳細(xì)展示視網(wǎng)膜的分層結(jié)構(gòu),揭示深層病變特征,但對表面顏色和紋理的判斷則相對不足。然而,當(dāng)提供多模態(tài)信息(cfp/oct圖像和臨床記錄)時,專家在推薦轉(zhuǎn)診時的診斷錯誤更少。由于缺乏經(jīng)驗豐富的眼科醫(yī)生,越來越多的研究致力于基于cfp圖像、oct圖像或兩者結(jié)合的amd自動化篩查方法。

2、現(xiàn)有技術(shù)存在的問題是:

3、①大多數(shù)amd自動化篩查方法的準(zhǔn)確性和魯棒性依賴于大量高質(zhì)量標(biāo)注數(shù)據(jù)集的支持,而在眼科領(lǐng)域,由于高昂的標(biāo)注成本和隱私問題,這類數(shù)據(jù)集稀缺且難以獲取,這給自動化篩查系統(tǒng)的開發(fā)和優(yōu)化帶來了巨大的挑戰(zhàn)。

4、②現(xiàn)有研究中,利用在imagenet上預(yù)訓(xùn)練的權(quán)重作為模型的初始點進行遷移學(xué)習(xí),逐漸成為常用策略。近期,一種名為retfound的模型受到廣泛關(guān)注,作為基于visiontransformer(vit)的通用視網(wǎng)膜基礎(chǔ)模型,該模型通過在大規(guī)模無標(biāo)注的視網(wǎng)膜圖像數(shù)據(jù)上進行預(yù)訓(xùn)練,學(xué)習(xí)到豐富的視覺特征表示,在后續(xù)任務(wù)中僅需有限的有標(biāo)注數(shù)據(jù)即可進行高效微調(diào)。值得注意的是,該模型在單模態(tài)下識別與眼部健康相關(guān)的復(fù)雜模式和特征方面表現(xiàn)出色。然而,retfound作為單模態(tài)模型,其結(jié)構(gòu)僅能處理單一模態(tài)數(shù)據(jù),這在一定程度上限制了其對視網(wǎng)膜病變特征的全面捕捉。特別是在診斷amd等復(fù)雜病變時,僅依賴單模態(tài)數(shù)據(jù)可能導(dǎo)致部分關(guān)鍵病理信息的丟失。相比之下,多模態(tài)數(shù)據(jù)融合能夠結(jié)合不同模態(tài)的優(yōu)勢,提供更加全面和細(xì)致的病變描述。因此,在下游任務(wù)微調(diào)的過程中,將多模態(tài)信息整合到retfound模型中,以提升其對amd復(fù)雜病變的識別能力和診斷準(zhǔn)確性,是一個值得探索的重要方向。

5、③在實際應(yīng)用中,多模態(tài)模型的訓(xùn)練和微調(diào)過程中面臨著計算復(fù)雜度和模態(tài)融合的雙重挑戰(zhàn)。隨著模態(tài)數(shù)量的增加,模型參數(shù)量將成倍增長,導(dǎo)致計算開銷顯著增加,特別是在整合cfp和oct圖像進行amd診斷時,這種復(fù)雜性尤為明顯。

6、④不同模態(tài)特征之間的異質(zhì)性進一步增加了有效信息融合的難度,如何在確保計算效率的前提下充分發(fā)揮各模態(tài)的互補優(yōu)勢仍然是一個關(guān)鍵問題。

技術(shù)實現(xiàn)思路

1、為此,本發(fā)明提供一種黃斑變性分類系統(tǒng)的構(gòu)建方法及黃斑變性分類系統(tǒng),旨在解決現(xiàn)有技術(shù)中的amd自動化篩查方法存在的訓(xùn)練數(shù)據(jù)難以獲取、識別能力不足、準(zhǔn)確率低以及無法確保計算效率的技術(shù)問題。

2、為實現(xiàn)以上目的,本發(fā)明采用如下技術(shù)方案:

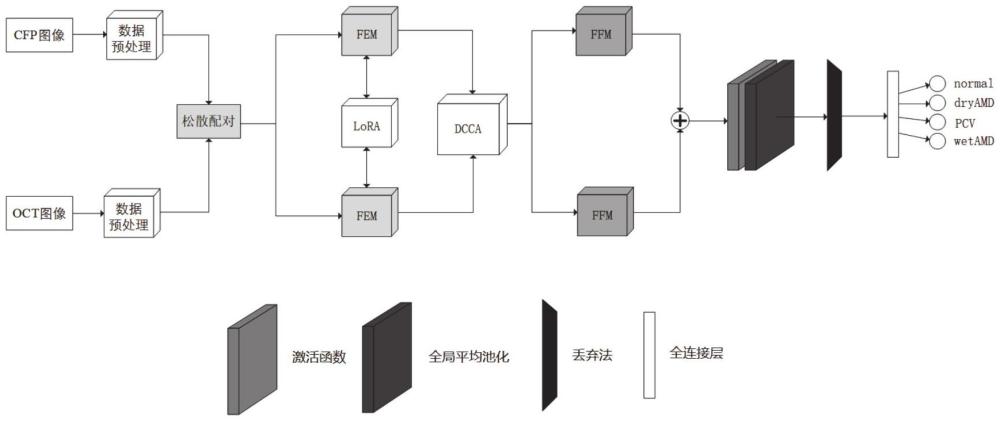

3、依據(jù)本發(fā)明第一方面,本發(fā)明提供一種黃斑變性分類系統(tǒng)的構(gòu)建方法,所述方法包括:

4、獲取攜帶有不同amd變性標(biāo)簽的多個訓(xùn)練樣本,形成多模態(tài)amd圖像數(shù)據(jù)集;其中,每個所述訓(xùn)練樣本均包括oct圖像和cfp圖像;所述amd變性標(biāo)簽包括正常、干性、濕性以及息肉樣脈絡(luò)膜血管病變;

5、利用松散配對技術(shù)對所述多模態(tài)amd圖像數(shù)據(jù)集中的oct圖像和cfp圖像進行相同amd變性標(biāo)簽配對,得到多組oct-cfp訓(xùn)練樣本對;

6、構(gòu)建融合低秩自適應(yīng)技術(shù)的特征提取模塊,利用所述特征提取模塊對所述oct-cfp訓(xùn)練樣本對進行特征提取,得到oct高緯特征向量和cfp高緯特征向量;

7、構(gòu)建基于神經(jīng)網(wǎng)絡(luò)的深度典型相關(guān)性分析模塊,分別對所述oct高緯特征向量和所述cfp高緯特征向量進行非線性特征變換,得到共享空間中相關(guān)性最大化的oct目標(biāo)特征向量和cfp目標(biāo)特征向量;

8、構(gòu)建基于多模態(tài)的特征融合模塊,對所述oct目標(biāo)特征向量和所述cfp目標(biāo)特征向量進行特征融合,輸出目標(biāo)融合特征;

9、基于預(yù)設(shè)分類算法構(gòu)建分類器,將所述目標(biāo)融合特征作為所述分類器的輸入,輸出的亞性類別作為預(yù)測結(jié)果,所述amd變性標(biāo)簽作為實際結(jié)果,對所述分類器進行訓(xùn)練和驗證,得到損失函數(shù)最小化的目標(biāo)分類器;

10、整合所述松散配對技術(shù)、所述特征提取模塊、所述深度典型相關(guān)性分析模塊、所述特征融合模塊以及所述目標(biāo)分類器,得到用于進行amd變性分類的黃斑變性分類系統(tǒng)。

11、進一步地,所述利用松散配對技術(shù)對所述多模態(tài)amd圖像數(shù)據(jù)集中的oct圖像和cfp圖像進行相同amd亞性標(biāo)簽配對之前,所述方法還包括:

12、對所述多模態(tài)圖像數(shù)據(jù)集進行圖像預(yù)處理,得到預(yù)處理后的目標(biāo)圖像數(shù)據(jù)集;所述目標(biāo)圖像數(shù)據(jù)集中包括攜帶有不同amd變性標(biāo)簽的多個訓(xùn)練樣本;每個訓(xùn)練樣本包括預(yù)處理后的oct圖像和cfp圖像;其中,所述圖像預(yù)處理包括以下步驟:

13、s1:刪除所述多模態(tài)圖像數(shù)據(jù)集中的異常圖像數(shù)據(jù),得到第一圖像數(shù)據(jù)集;

14、s2:針對所述第一圖像數(shù)據(jù)集中的第一圖像數(shù)據(jù)進行圖像歸一化處理、圖像加權(quán)增強處理,得到第二圖像數(shù)據(jù)集;

15、s3:針對所述第二圖像數(shù)據(jù)集中的第二圖像數(shù)據(jù)進行圖像增強中處理。

16、進一步地,所述圖像歸一化處理包括針對圖像像素的通道數(shù)值范圍進行歸一處理、針對圖像像素的均值化處理、針對圖像像素的標(biāo)準(zhǔn)化處理以及針對圖像尺寸的一致化調(diào)整中至少之一;

17、和/或,

18、所述圖像加權(quán)增強的處理公式表示為:

19、iweight=iorg*α+iblur*β+γ

20、iblur=iorg*kernalh×w

21、其中,iweight為第二圖像數(shù)據(jù);iorg為第一圖像數(shù)據(jù);iblur為第一圖像數(shù)據(jù)經(jīng)過高斯模糊后的圖像,kernalh×w表示尺寸為h×w的高斯核;α、β為加權(quán)系數(shù);γ為常數(shù);

22、和/或,

23、所述圖像增強包括圖像旋轉(zhuǎn)、圖像平移、隨機翻轉(zhuǎn)、針對cfp圖像應(yīng)用對比度受限自適應(yīng)直方圖均衡化以及針對oct圖像應(yīng)用中值濾波方法中至少之一。

24、進一步地,所述利用松散配對技術(shù)對所述多模態(tài)amd圖像數(shù)據(jù)集中的oct圖像和cfp圖像進行相同amd變性標(biāo)簽配對,得到多組oct-cfp訓(xùn)練樣本對,包括:

25、針對所述目標(biāo)圖像數(shù)據(jù)集iaug中的每個訓(xùn)練樣本i,將其中的cfp圖像(iaug_fi)和oct圖像(iaug_oi)作為原始配對;

26、初始化一個空的松散配對列表;

27、針對所述目標(biāo)圖像數(shù)據(jù)集中的其他訓(xùn)練樣本j(j≠i),若所述訓(xùn)練樣本i和所述訓(xùn)練樣本j的amd變性標(biāo)簽相同,則將(iaug_fi,iaug_oj)和(iaug_fj,iaug_oi)添加到所述松散配對列表;

28、將所述原始配對和所述松散配對列表進行合并,得到擴充多組oct-cfp訓(xùn)練樣本對的多模態(tài)amd圖像集。

29、進一步地,所述構(gòu)建融合低秩自適應(yīng)技術(shù)的特征提取模塊,利用所述特征提取模塊對所述oct-cfp訓(xùn)練樣本對進行特征提取,得到oct高緯特征向量和cfp高緯特征向量,包括:

30、構(gòu)建包含兩個獨立的vit-large編碼器的特征提取模塊;所述vit-large編碼器包含patch?embedding層、24個transformer塊和一個1024維的嵌入向量;

31、分別將所述oct-cfp訓(xùn)練樣本對中的cfp圖像(xcfp∈rh×w×c)和oct圖像(xoct∈rh×w×c)輸入到兩個獨立的vit-large編碼器中;

32、通過patch?embedding層分割為固定大小的patch,映射為1024維的嵌入向量,分別記為pcfp∈r1×1024和poct∈r1×1024;

33、利用位置編碼對所述嵌入向量進行處理,生成相應(yīng)的輸入特征向量,分別記為z0cfp∈r1×1024和z0oct∈r1×1024;

34、將所述輸入特征向量輸入transformer塊對進行處理,輸出公式表示為:

35、

36、經(jīng)過24個transformer塊處理后,得到待轉(zhuǎn)換高緯特征向量zcfp∈r1×1024和zoct∈r1×1024。

37、所述方法還包括:

38、利用所述低秩自適應(yīng)技術(shù)對所述transformer塊的自注意力層中的查詢矩陣wq和值投影矩陣wv進行低秩分解,以優(yōu)化權(quán)重更新,公式表示如下:

39、δw=ba

40、其中,b∈rd×r和a∈rr×d為低秩分解產(chǎn)生的矩陣,秩r遠(yuǎn)小于維度d;

41、利用權(quán)重更新優(yōu)化后的transformer塊對所述輸入特征向量進行處理,得到oct高緯特征向量hoct∈r1×1024和cfp高緯特征向量hcfp∈r1×1024,公式表示如下:

42、h=w0z+δwz=w0z+baz

43、其中,w0為初始預(yù)訓(xùn)練權(quán)重;δw為低秩分解后的權(quán)重更新項;z為待轉(zhuǎn)換高緯特征向量。

44、進一步地,所述構(gòu)建基于神經(jīng)網(wǎng)絡(luò)的深度典型相關(guān)性分析模塊,分別對所述oct高緯特征向量和所述cfp高緯特征向量進行非線性特征變換,得到共享空間中相關(guān)性最大化的oct目標(biāo)特征向量和cfp目標(biāo)特征向量;

45、構(gòu)建包含兩個獨立的深度神經(jīng)網(wǎng)絡(luò)的深度典型相關(guān)性分析模塊,分別將所述oct高緯特征向量和所述cfp高緯特征向量輸入兩個獨立的深度神經(jīng)網(wǎng)絡(luò)進行多次非線性變換,生成輸出特征ocfp∈rn×d和ooct∈rn×d,公式表示如下:

46、ocfp=fcfp(hcfp,w1),ooct=foct(hoct,w2)

47、其中,分別為cfp實例特征矩陣和oct實例特征矩陣;n為實例數(shù)量;d1為cfp模態(tài)的特征維度;d2為oct模態(tài)的特征維度;w1和w2分別為兩個深度神經(jīng)網(wǎng)絡(luò)進行非線性變換的參數(shù);d為輸出維度;

48、將所述輸出特征進行中心化處理,構(gòu)建跨模態(tài)的協(xié)方差矩陣:

49、

50、其中,σ11和σ22分別表示cfp模態(tài)的協(xié)方差矩陣和oct模態(tài)的協(xié)方差矩陣;σ12為跨模態(tài)的協(xié)方差矩陣;

51、利用以下公式最大化輸出特征ocfp和ooct在共享空間中的相關(guān)性,得到oct目標(biāo)特征向量和cfp目標(biāo)特征向量,公式表示如下:

52、

53、進一步地,所述構(gòu)建基于多模態(tài)的特征融合模塊,對所述oct目標(biāo)特征向量和所述cfp目標(biāo)特征向量進行特征融合,輸出目標(biāo)融合特征,包括:

54、將所述oct目標(biāo)特征向量和所述cfp目標(biāo)特征向量作為輸入特征,初始化滑動平均變量yavg為零矩陣,尺寸與輸入特征一致;

55、更新滑動平均變量yavg,公式表示如下:

56、yavg=β·yavg+(1-β)·yt

57、其中,β為滑動平均衰減系數(shù);yt為當(dāng)前時刻的輸入特征;yt為時刻t時oct目標(biāo)特征向量與cfp目標(biāo)特征向量按照元素相乘的結(jié)果;

58、輸出融合特征youtput=y(tǒng)avg;

59、將youtput作為下一時刻t+1的輸入;

60、選擇特定時間步t*作為終止,輸出最終的目標(biāo)融合特征。

61、進一步地,所述預(yù)設(shè)分類算法包括支持向量機、隨機森林、k最近鄰算法、多層感知機中至少之一;

62、損失函數(shù)公式表示為:

63、

64、其中,為分類損失函數(shù);為深度典型相關(guān)性損失函數(shù);n為訓(xùn)練樣本數(shù)量;c為類別數(shù)量;yi,j為訓(xùn)練樣本i的實際結(jié)果;為訓(xùn)練樣本i的預(yù)測結(jié)果為類別j的概率;λ為用于平衡分類損失和深度典型相關(guān)性損失對分類器訓(xùn)練影響的損失權(quán)重。

65、依據(jù)本發(fā)明第二方面,本發(fā)明提供一種根據(jù)本發(fā)明第一方面任一項所述的黃斑變性分類系統(tǒng)的構(gòu)建方法構(gòu)建的黃斑變性分類系統(tǒng),所述系統(tǒng)包括:松散配對模塊、特征提取模塊、深度典型相關(guān)性分析模塊、特征融合模塊以及目標(biāo)分類器;

66、所述松散配對模塊用于獲取待分類的oct圖像和cfp圖像,利用松散配對技術(shù)對所述oct圖像和所述cfp圖像進行相同amd變性標(biāo)簽配對,得到多組oct-cfp訓(xùn)練樣本對;

67、所述特征提取模塊用于所述oct-cfp訓(xùn)練樣本對進行特征提取,得到經(jīng)過基于低秩自適應(yīng)技術(shù)的特征轉(zhuǎn)換后的oct高緯特征向量和cfp高緯特征向量;

68、所述深度典型相關(guān)性分析模塊用于對所述oct高緯特征向量和所述cfp高緯特征向量進行非線性特征變換,得到共享空間中相關(guān)性最大化的oct目標(biāo)特征向量和cfp目標(biāo)特征向量;

69、所述特征融合模塊用于對所述oct目標(biāo)特征向量和所述cfp目標(biāo)特征向量進行特征融合,得到目標(biāo)融合特征;

70、所述目標(biāo)分類器用于將所述目標(biāo)融合特征作為輸入,輸出所述待分類的oct圖像和cfp圖像對于的amd變性類別;

71、其中,所述amd變性類別包括正常、干性、濕性以及息肉樣脈絡(luò)膜血管病變。

72、本發(fā)明采用以上技術(shù)方案,至少具備以下有益效果:

73、通過本發(fā)明方案,對大型預(yù)訓(xùn)練的單模態(tài)視網(wǎng)膜基礎(chǔ)模型進行精細(xì)化微調(diào),以實現(xiàn)多模態(tài)amd識別。本發(fā)明不僅關(guān)注如何在微調(diào)過程中有效擴展模型以整合多模態(tài)數(shù)據(jù),還著重于降低計算成本和優(yōu)化模態(tài)間的信息融合。考慮到在多模態(tài)數(shù)據(jù)整合過程中計算復(fù)雜度的顯著增加,本發(fā)明采用了low-rank?adaptation(lora)方法,通過引入低秩矩陣的適應(yīng)機制,將全參數(shù)矩陣分解為兩個低秩矩陣的乘積,從而在微調(diào)時僅對模型的部分參數(shù)進行優(yōu)化調(diào)整。此方法顯著降低了計算負(fù)擔(dān)和內(nèi)存需求,同時確保模型在處理多模態(tài)數(shù)據(jù)時的性能和準(zhǔn)確性不受影響。為了彌合不同模態(tài)特征的異質(zhì)性,本發(fā)明還引入了深度典型相關(guān)性分析(dcca)方法,通過兩個獨立的神經(jīng)網(wǎng)絡(luò)對cfp和oct模態(tài)特征之間的細(xì)粒度跨模態(tài)下的非線性特征變換,并結(jié)合經(jīng)典的典型相關(guān)性分析(cca)進行正則化,以最大化兩種模態(tài)特征之間的線性相關(guān)性。在訓(xùn)練過程中,兩種模態(tài)的特征被映射到一個協(xié)調(diào)的高維超空間中,使模型能夠?qū)W習(xí)到高度相關(guān)的多模態(tài)特征。另外需要說明的是,本發(fā)明完全保留了大型預(yù)訓(xùn)練單模態(tài)視網(wǎng)膜基礎(chǔ)模型的原始網(wǎng)絡(luò)結(jié)構(gòu),從而確保單模態(tài)下的特征處理能力不受影響。

74、應(yīng)當(dāng)理解的是,以上的一般描述和后文的細(xì)節(jié)描述僅是示例性和解釋性的,并不能限制本發(fā)明。

- 還沒有人留言評論。精彩留言會獲得點贊!